轮对作为列车的走行部件,其踏面因长期与铁轨接触作业,不可避免地发生踏面损伤现象;若无法及时检测与整修,可能导致驻车失效等严重行车事故。白堂博等[1]基于图像视觉的缺陷检测方法被广泛应用于工业缺陷检测中。然而,踏面缺陷检测面临多尺度、背景复杂等问题,使得传统的检测方法难以直接迁移应用。近年来,基于深度学习的目标检测算法成为缺陷检测的主流,为踏面缺陷检测带来了新的解决方案。目前,深度学习目标检测算法主要分为Anchor-based和Anchor-free这2类。Anchor-based方法又可分为单步检测器和两步检测器2类。单步检测通常包括YOLO、SSD、RetinaNet等方法[2-4],可在不使用区域提议网络(RPN)的情况下完成回归和分类。这类方法虽然具有较快的检测速度,但检测精度不佳,其原因是此类方法难以确定先验锚框的超参数。两步检测器(如Faster R-CNN[5]、Libra R-CNN[6]和Cascade R-CNN[7])能够通过PRN网络有效地提升检测精度,但需承担额外的计算时间。Anchor-free类方法可以直接估计物体质心并通过关键点或角点回归其边界框,因而应用场景更为灵活。例如MA等[8]根据CornerNet中每个角点所形成预测边界开展匹配度评价,从而实现更全面的关键点匹配。LIU等[9]在CenterNet基础上设计了基于知识蒸馏的新型Anchor-free方法用于表面缺陷检测。陈强等[10]针对接触网缺陷问题,提出一种基于FCOS和ResNet50-F的检测方法,并取得了良好的检测效果。然而,这类方法对于复杂背景和多尺度情况下的检测能力不佳。现有研究表明注意力机制可以在弱化非关键背景特征的同时加强特征图中的判别特征[11],而多尺度特征模块[12-14]能够有效优化模型提取多尺度信息的能力。因此,本文将注意力机制与多尺度特征融合思想引入Anchor-free检测器,以优化模型检测性能。然而,特征增强模块的引用易增加模型的复杂度和计算量,因而有悖于工业领域低算力的要求。为降低所提模型的冗余度、提高其工业现场可用性、经济性,国内外学者逐渐开始关注知识蒸馏策略[15-20]。知识蒸馏可以通过将复杂教师模型的知识转移到简单学生模型中以实现模型压缩,例如PARK等[21]提出基于距离-角度的蒸馏损失来表示师生网络的结构关系;CHEN等[22]利用知识蒸馏将提示学习和KD损失同时用于多类别目标检测;LI等[23]使用知识蒸馏模仿 Faster R-CNN中的区域内特征以提高模型表征能力;WANG等[24]通过蒸馏模仿了接近锚框的细粒度特征。值得一提的是,上述方法在蒸馏过程中皆同等对待蒸馏区域,没有考虑不同区域之间的重要程度。因此,尽管此类方法在分类任务上表现良好,但难以直接应用于复杂目标检测任务。针对上述问题,本文提出一种基于多尺度可分离蒸馏网络的无锚检测器用于检测列车轮对踏面缺陷,称为D-MSCNet。本文的主要贡献如下:

1) 设计一种新的由跨层可分离特征提取模块(CSEM),该基础块通过引入深度可分离卷积、通道压缩和跨层线性特征复用结构等机制,能够在维持特征提取效率的同时减少模型计算量、加快计算速度;

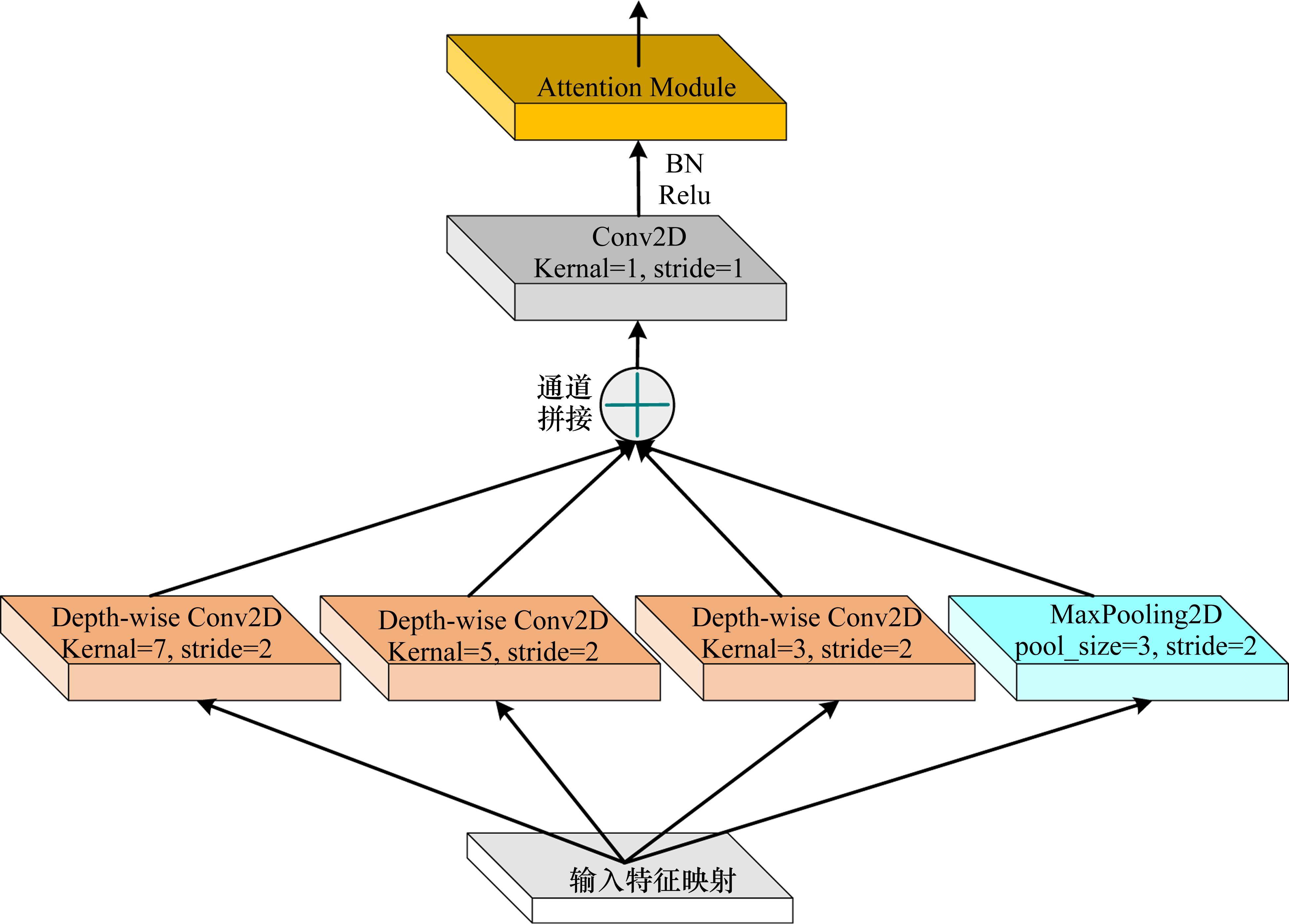

2) 提出一种新的多尺度可分离下采样模块(MSDM),其中的注意力机制和多尺度特征融合结构能够辅助模型提取多尺度特征和弱化背景干扰的能力;

3) 提出一种新的主从区域知识蒸馏策略对检测器进行压缩。该法先根据标签信息划分主蒸馏区域和二次蒸馏区域,然后将两者作用于教师和学生网络的回归分支之间;

4) 提出一种基于多尺度可分离蒸馏网络的无锚检测器(D-MSCNet),该模型通过集成 CSEM、MSDM模块以及主从区域知识蒸馏策略,在列车轮对踏面缺陷检测任务上实现了检测速度和精度的平衡。

1 本文所提方法描述

1.1 基于多尺度可分离蒸馏网络的列车轮对踏面缺陷检测算法

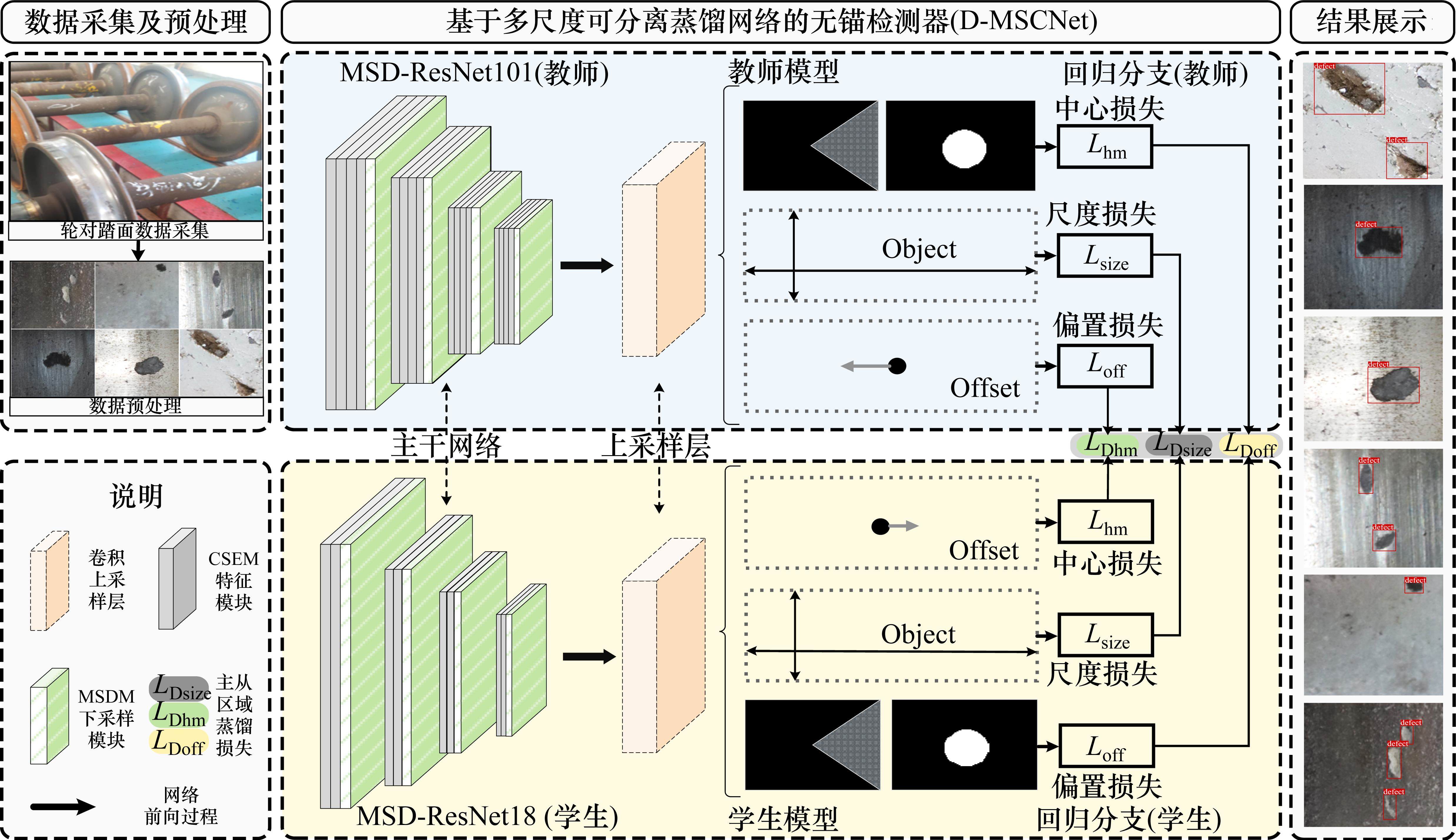

本文在 CenterNet[9] 的基础上提出一种新的基于多尺度可分离蒸馏网络的无锚检测器(An anchor-free detector based on multi-scale separable distillation network, D-MSCNet)。该法由知识蒸馏策略、改进主干网络、上采样层和3个回归分支组成,具体结构如图1所示。其中,知识蒸馏被定义为教师网络和学生网络回归分支输出间的信息交互,通过“大型高效”的教师模型指导“轻量快速”的学生模型以实现模型压缩。

1.1.1 跨层可分离提取模块(CSEM)及多尺度可分离下采样模块(MSDM)

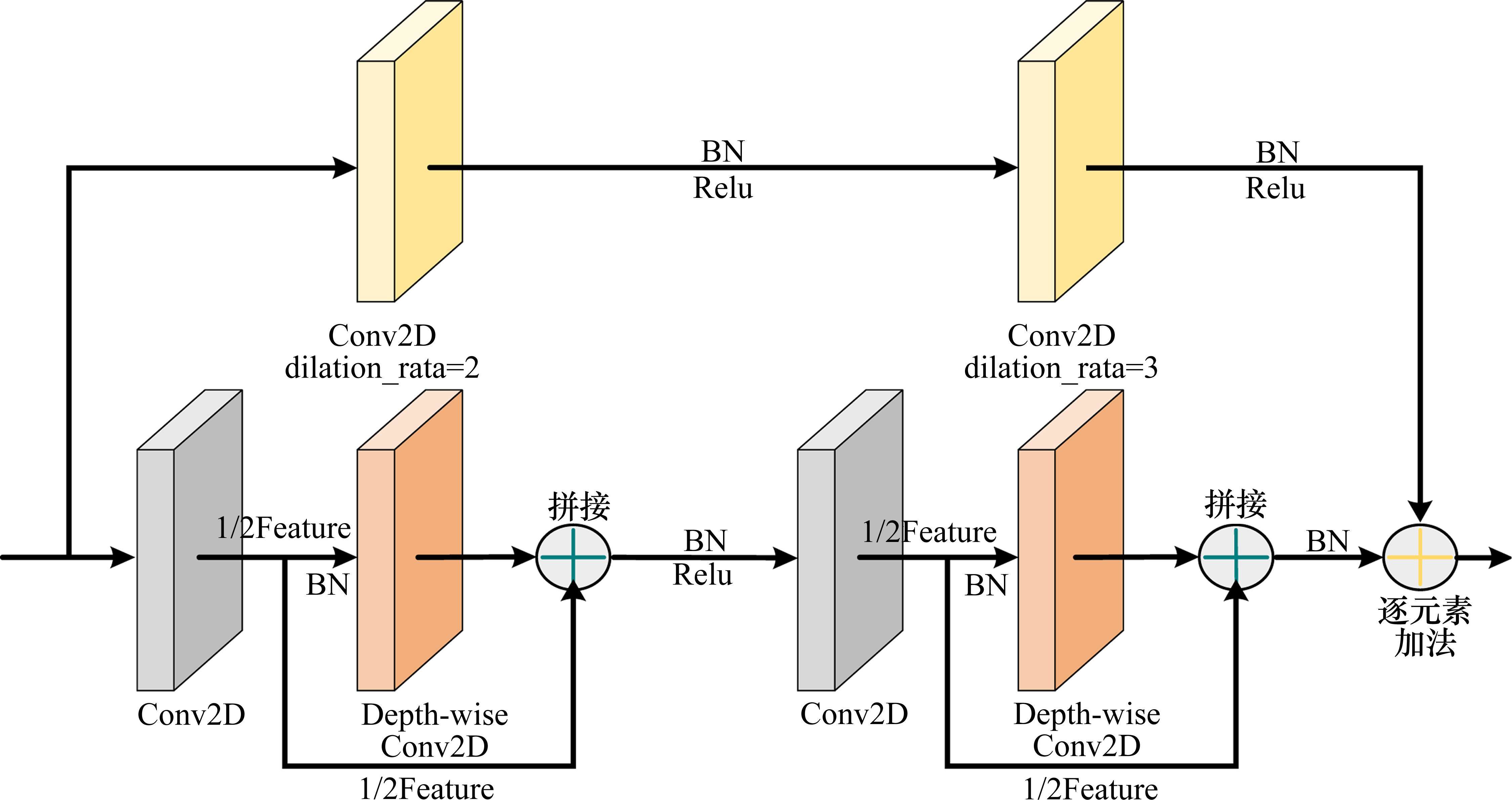

在CSEM的整体设计中,首先将内部的低维通道映射到高维以丰富缺陷特征表达;输出部分对高维通道进行压缩和降维以减少参数,以保障MSA-ResNet具有更快的计算速度。通常浅层残差结构中存在较为相似的冗余特征[15]。为此,本文在CSEM主干上设计了“跨层线性特征复用结构”,以保障卷积网络能对输入数据更全面地理解同时减少计算量,其结构如图2所示。

利用通道压缩卷积(输出通道数为输入通道的1/2)将输入特征通道数压缩,以得到基准特征图F;然后,采用深度可分离卷积对F进行计算,以生成通道维度相同的特征图F';最后,将特征图F复用并与F'进行特征拼接(线性融合),以形成高维通道特征图T,其表达公式如下。

其中,X表示通道、高度和宽度分别为C、H和W的特征图;*表示卷积操作;b表示偏置项;f∈RC×K×K×(C/2)表示对应层的卷积核;F∈R(C/2)×H×W表示通道维数为C/2的基准特征映射。然后,将F用于计算新的特征图F'。

式中:φ表示深度可分离卷积操作;F'∈R(C/2)×H×W表示通道为C/2的可分离特征映射。最后,将F和F'进行融合以获取特征图Z。

式中:⊕表示通道拼接操作;Z∈RC×H×W表示线性复用特征图(在CSEM中,公式(1)~(3)被执行2次以优化其特征提取效率,则经2次操作后的输出为T∈RC×H×W)。相较于传统方法,线性特征复用结构能够有效地提高检测速度。此外,线性运算生成的特征图具有更高的信息相关性,有利于缺陷特征信息的补充表达。在快捷支路(副路)上,采用一种混合卷积模块(由2个不同扩张率的扩展卷积组成)来有效地保存缺陷特征信息在连续卷积操作过程中的连续性、完整性并扩大特征图感受野。

式中:ψ表示混合扩展卷积操作;T'∈RC×H×W表示通道为C的副路输出特征。然后,将主路与支路的特征图进行跨层融合以进一步扩张感受野。

其中,+表示逐元素加法;M∈RC×H×W表示通道为C的融合特征图。

池化是最常见的下采样操作,可以过滤感受野的特征并提取该区域最重要的特征信息。然而,池化通常存在以下问题:1) 可能使网络模型失去平移不变性;2) 易导致缺陷判别性信息(纹理信息、边缘信息)丢失;3) 本质上是一种无法学习的静止操作,难以处理干扰因素和多尺度缺陷。因此,本节提出一种多尺度可分离下采样模块(MSDM),实现下采样过程中提取图像多尺度特征和增强判别性缺陷特征,其结构如图3所示。MSDM将输入分为4个分支,在前3个中分别使用了7×7、5×5和3×3且步长(strides)皆为2的卷积核来进行卷积运算,以在不同尺度上提取更加全面的缺陷特征。在第4个分支中,步长为2的最大池化层被运用以提取更加显著的缺陷特征。然后,先对每个分支的输出进行特征融合,再使用1×1卷积对融合特征进行整合和通道压缩,以进一步丰富缺陷特征信息并减少计算量。最后,为了保证模块能够更加关注缺陷中的判别性特征,采用注意模块(SEblock)来增强特征图中关键区域的显著性,并减少复杂背景等冗余信息的干扰。需要注意的是,由于采用了计算量较小的深度可分离卷积,其能在同等计算量的条件下允许采用大卷积核来扩大感受野。

1.1.2 多尺度可分离注意残差网络(MSA-ResNet)和主从区域知识蒸馏策略

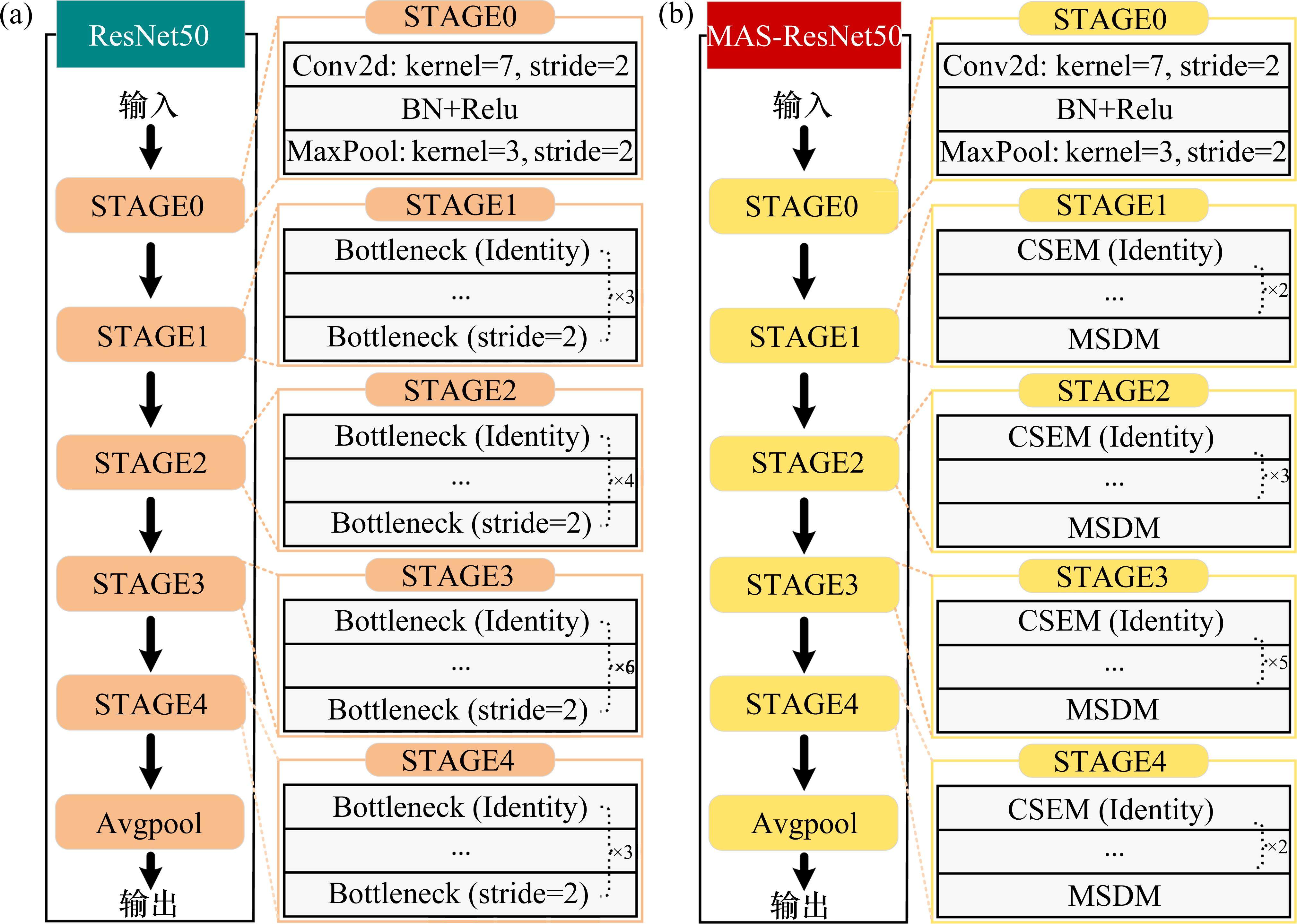

原始的CenterNet使用深度残差网络(ResNet)作为主干,主要通过堆叠Bottleneck模块构建特征提取网络,在多尺度和复杂背景的工业条件下,ResNet难以有效提取缺陷图像的特征。本文将所提的CSEM和MSDM模块引入到ResNet中,以提升主干网络的多尺度特征提取和过滤复杂背景信息的能力,其结构如图4所示。具体地,分别使用CSEM模块和MSDM下采样模块替代原始ResNet中的瓶颈块(Bottleneck)和每个阶段(stage)中步长(stride)为2的下采样卷积。由于CSEM和MSDM模块中包含了特征增强技巧(注意力机制、多尺度结构、跨层残差连接、特征融合)、感受野扩大模块(扩展卷积)和网络轻量化方法(通道压缩结构、深度可分离卷积),使得所设计的主干网络(MSA-ResNet)能够有效地在具有踏面缺陷检测任务上保持检测速度和检测精度的平衡。

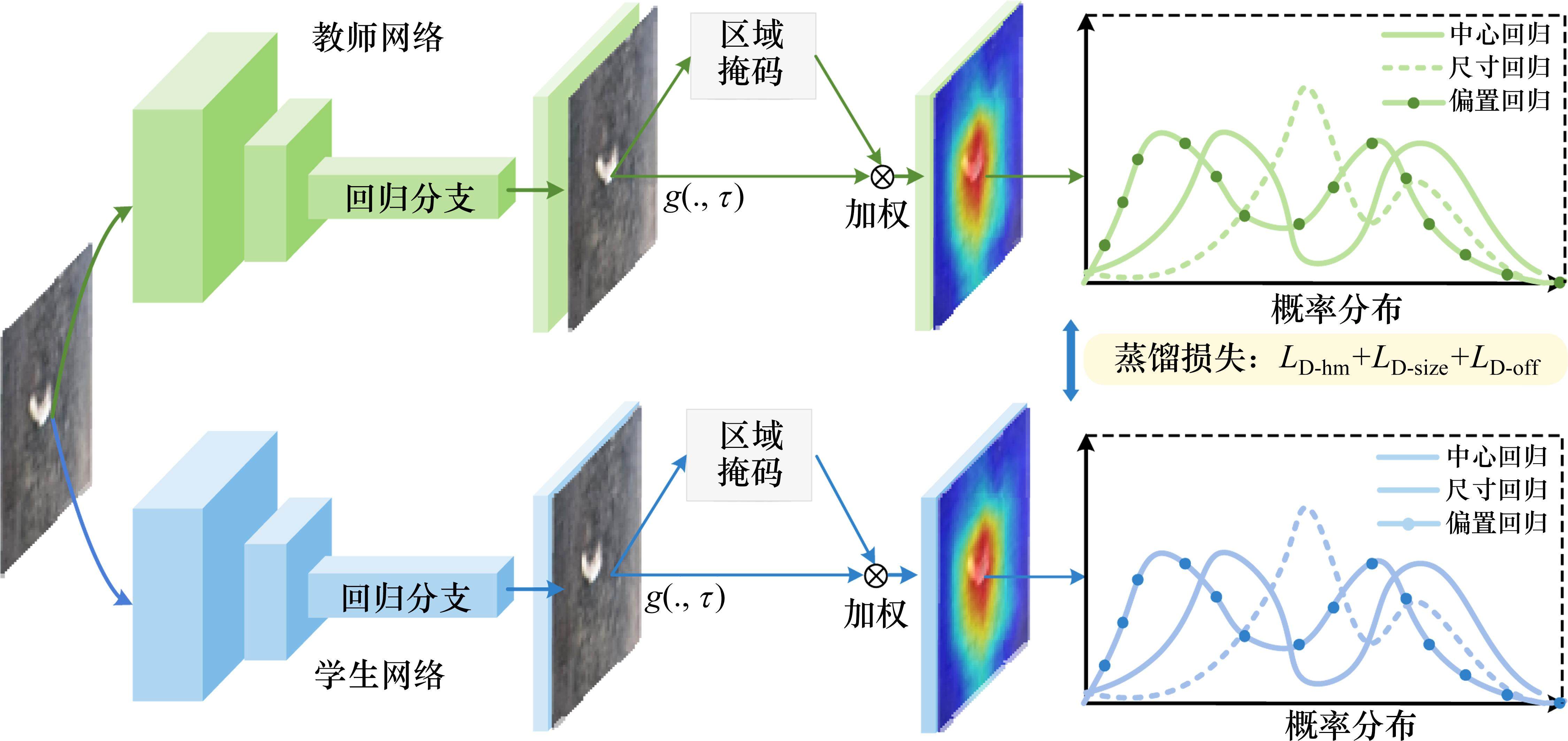

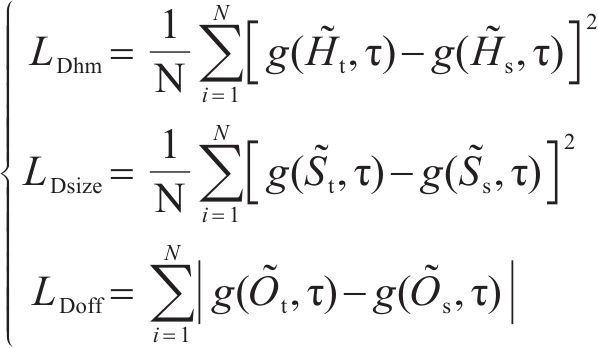

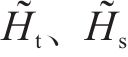

众所周知,“更宽-更深”的神经网络相较于“即浅又窄”的网络在特征提取性能上具有显著的优势。因此,目前许多高性能目标检测算法都采用大模型或“更宽更深”的神经网络作为主干网络。然而,大参数模型与“低计算能力、高检测速度”的工业需求相悖。为此,本文在D-MSCNet中利用知识蒸馏策略将主干为MSA-ResNet101的CenterNet检测器的知识转移到轻量级的MSA-ResNet18中,具体设计如图5所示。绿色和蓝色的网络分别代表教师模型和学生模型;g(., τ)表示温度为τ的广义Softmax函数。对于给定的分支预测映射,首先根据Ground True中的标签信息分别生成主从区域掩码矩阵,并使用掩码矩阵对分支预测映射加权以确定主要和次要蒸馏区域;进而使用g(., τ)将加权后的映射结果转换为概率分布,以便于教师和学生网络间的信息交互;最后分别计算教师网络与学生网络之间的中心、尺度和偏置蒸馏损失。通过这种“分而治之”的方式既能够在每个回归分支上将知识交互的重点集中在主蒸馏区域,能够避免不同回归分支之间的知识发生混淆。

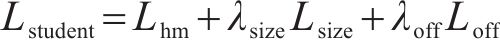

1.2 损失函数

为了有效地执行知识蒸馏任务和训练目标检测器,本文设计了一种新的全局损失函数。该损失函数所包含的组件如下所示:1)中心预测损失函数Lhm;2)尺寸回归损失函数Lsize;3)中心偏置预测损失函数Loff;4)学生网络训练损失函数Lstudent;5) 蒸馏损失函数LD。

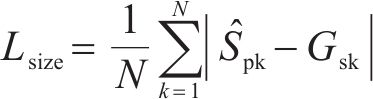

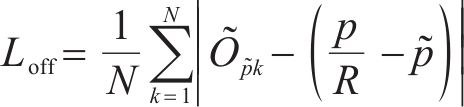

1.2.1 学生网络训练损失

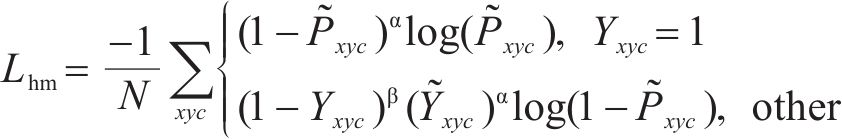

学生网络训练损失主要由Lhm、Lsize和Loff这3个组件组成。首先,将中心预测损失函数Lhm定义为如下所示形式。

式中:

式中:

式中:

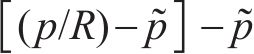

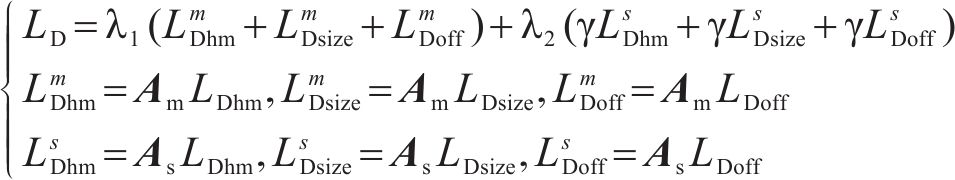

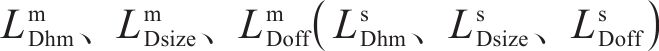

1.2.2 主从区域蒸馏损失

本文所提出的蒸馏损失主要由主蒸馏区域损失和次蒸馏区域损失组成,具体内容如下所示:

式中:

式中:

| 算法A:蒸馏区域掩码矩阵伪代码(Pytorch-like) |

|---|

| # center_heatMAP表示学生网络的中心点预测热力图 |

| # labels表示ground truth中的类别标签 |

| # num_cls 表示目标类别的数量 |

| pos_inds=((labels>=0) & (labels<num_cls)).nonzero().squeeze(1) |

| remain_inds = (labels = num_cls + 1).nonzero().squeeze(1) |

| Am = Sigmoid(center_heatMAP).max(dim=1)[0][pos_inds] |

| As = Sigmoid(center_heatMAP).max(dim=1)[0][remain_inds] |

1.2.3 全局损失函数

本文所设计的全局损失函数Lglobal由学生模型训练损失函数Lstudent和主从区域蒸馏损失函数LD组成,具体内容如下所示。

2 实验和分析

本文数据集采自某轮对车间,在装载AMD Ryzen 9 5900HX CPU、NVIDIA RTX 3080 GPU、32G RAM 的PC端Pytorch深度学习平台上进行实验。软件环境为CUDA11.3、cuDNN8.7.0、Torch1.9、Python3.9和MMdetection2.28。实验使用随机梯度下降法(SGD)作为优化器(权重衰减和动量分别为0.000 1和0.9),并在训练前的500个Step中逐渐将学习率从1×10-5线性增加到1×10-3,而在14和22个Epoch之后依次将学习率降低10倍。此外,在使用轮对踏面缺陷数据训练前,本文使用 Paslcal VOC 2012数据集对模型进行预训练以提高模型训练效率。最后,模型训练的Batch-size和Epoch分别被设置为128和35。

2.1 数据集介绍

实验数据集是在某车辆段中由CCD相机以统一的标准采集所得。CCD相机参数如下所示:1) 型号为Allied Vision Technologies Prosilica GT1910;2) CCD 传感器尺寸为5.5×5.5 μm;3) 分辨率为1 920×1 080。该数据总共包括1 029张轮对踏面缺陷图像,部分图像如图6所示。此外,分别选取823和206张图片作为训练集和测试集。

2.2 性能指标评估

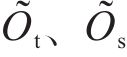

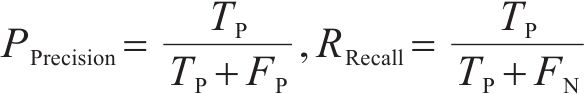

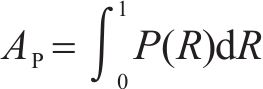

本文采用MAP、AP、Precision(P)、Recall(R)等常用的检测精度指标来评估缺陷检测模型的整体性能,而这些指标定义如下所示。

式中:TP、FP、FN分别表示正确检测的踏面缺陷数量、假报警数量和未检测到的缺陷数量。此外AP表示PR曲线的关于坐标轴的面积,与检测性能呈正相关。

式中:P和R分别表示精确率和召回率。MAP表示每个类别AP的平均得分。此外,本文还引入了每秒传输帧数(Frames Per Second, FPS)、浮点运算次数(Floating Point Operations, FLOPs)和模型参数量 (Parameter, Pa)作为模型计算量和计算速度的评价指标。

2.3 模型算法

本文提出的D-MSCNet的执行步骤如表2所示。

| 算法 B:D-MSCNet 检测器执行步骤 |

|---|

| 输入:输入列车轮对踏面数据集的训练集和测试集。 |

| 步骤1:先将输入图像的短边随机缩放到800~1 333之间,长边设为短边的1.5倍。然后,对缩放后的图像进行归一化。 |

| 步骤2:采用原始CenterNet的训练方法对主干为MSA- ResNet101的CenterNet无锚检测器进行预训练,并保存其最优模型以作为教师网络。 |

| 步骤3:类似于教师网络的前向过程,将处理后的图像输入到学生网络和教师网络中,以生成学生模型和教师模型的中心点热图预测分支、尺寸预测分支和偏移预测分支的输出值。(学生网络为加载MSA-ResNet50或MSA-ResNet18的CenterNet检测器) |

| 步骤4:根据学生网络和教师网络所对应3回归分支的输出值和公式(7)~(13)计算全局损失函数。 |

| 步骤5:通过最小化全局损失函数来训练模型,并保存综合性能最佳的学生网络参数。 |

| 步骤6:利用测试集对模型进行测试并输出最终结果。 |

2.4 对比实验分析

为了有效地验证所提方法的有效性,本文将所提方法与一些经典的目标检测方法进行了对比,如表3所示。表中所有实验结构均为5次随机训练和测试所得的平均值。本文对比方法上设置了ResNet101和MSA-ResNet101这2种实验。

| 方法 | Backbone | MAP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% | APtotal/% | Pa(M) | FLOPs | FPS |

|---|---|---|---|---|---|---|---|---|---|---|---|

| YOLOV3[2] | Darknet53 | 62.7 | 95.4 | 76.9 | 58.9 | 66.1 | 66.6 | 426.6 | 61.5 | 121.2 | 32 |

| DETR[25] | ResNet101 | 63.5 | 95.9 | 77.9 | 60 | 65.9 | 67.2 | 430.4 | 60.2 | 117.6 | 19 |

| MSA-ResNet101 | 65.5 | 96.7 | 78.6 | 63.5 | 67.8 | 68.7 | 440.8 | 65.4 | 129.2 | 16 | |

| Faster-RCNN[5] | ResNet101 | 60.5 | 93.8 | 74.8 | 56.5 | 64.1 | 63.8 | 413.5 | 60.1 | 169 | 17 |

| MSA-ResNet101 | 62.8 | 94.9 | 76.7 | 58.5 | 66.3 | 65.4 | 424.6 | 66.5 | 181.2 | 14 | |

| Cascade-RCNN[7] | ResNet101 | 63.3 | 95.6 | 77.2 | 58.6 | 68.5 | 67.8 | 431.0 | 87.9 | 171.1 | 12 |

| MSA-ResNet101 | 65.5 | 96.4 | 79.8 | 61 | 69.5 | 69.7 | 441.9 | 93.2 | 182.6 | 8 | |

| CornerNet[8] | ResNet101 | 61.5 | 93.6 | 72.6 | 56.3 | 64.6 | 63 | 411.6 | 48.8 | 365.3 | 9 |

| MSA-ResNet101 | 63.7 | 94.6 | 74.2 | 59.2 | 67.4 | 64.5 | 423.6 | 54.1 | 376.9 | 4 | |

| FCOS[10] | ResNet101 | 62.1 | 93.4 | 73.2 | 56.7 | 64.5 | 63.8 | 413.7 | 50.8 | 160.5 | 23 |

| MSA-ResNet101 | 64.3 | 94.4 | 74.8 | 59.6 | 67.3 | 65.3 | 425.7 | 56.1 | 171.8 | 18 | |

| CenterNet[9] | ResNet101 | 63.8 | 95.9 | 77 | 58.8 | 67.6 | 67 | 430.1 | 49.3 | 107.3 | 51 |

| MSA-ResNet18 | 59.8 | 90.6 | 71.8 | 54.7 | 62.8 | 61.4 | 401.1 | 15.6 | 37.6 | 87 | |

| MSA-ResNet50 | 64.6 | 95.7 | 76.3 | 58.2 | 66.9 | 65.8 | 427.5 | 31.5 | 63.9 | 60 | |

| MSA-ResNet101 | 66.3 | 97.3 | 79.2 | 63 | 71 | 69.3 | 446.1 | 54.6 | 118.6 | 46 | |

| D-MSCNet | MSA-ResNet18 | 64.9 | 95.8 | 77.6 | 60.7 | 67.6 | 67.2 | 433.8 | 16.4 | 38.2 | 85 |

| MSA-ResNet50 | 66.2 | 97 | 78.8 | 62.5 | 69 | 68.6 | 442.1 | 32.4 | 65.8 | 58 |

由结果可知,相较于采用ResNet101的方法,以MSA-ResNet101为主干的检测方法在各项检测精度指标上具有约0.7%~4.2%的优势。此外,可以观察到加载MSA-ResNet的方法相较于ResNet101方法,在Pa、FLOPs和FPS指标上仅有5~6、11~12和3~5的劣势。这表明由CSEM和MSDM模块所构成的MSA-ResNet能够在牺牲少量计算量、参数量和计算速度的情况下有效地提升模型的检测性能。观察对比方法的实验结果可知,采用MSA-ResNet101为主干网络的CenterNet检测器不仅在MAP、AP50和APm指标上分别达到了66.3%、97.3%和71%,而且在FPS指标上具有明显的优势(FPS=46)。为了更加直观展示每种模型综合性能,本文对MAP、AP50、AP75、APs、APm和APl进行了求和,从而得到了一种新的综合性能指标(APtotal)。从实验结果上看,加载MSA-ResNet101的CneterNet检测器在APtotal指标上达到了最优(APtotal=446.1%)。可见,CenterNet(MSA-Res Net101)相较于其他对比方法更能有效地在检测速度和检测速度间保持平衡。

此外,实验采用 CenterNet(MSA-ResNet101)作为教师网络,并采用蒸馏策略对其进行进一步模型压缩以减少参数量、计算量并提高计算速度。进一步地,在D-MSCNet中设置了2个学生网络(MSA-ResNet18、MSA-ResNet50)的对比实验。由结果可知,当学生网络以MSA-ResNet50为主干网络时,其各项检测精度指标优于MSA-ResNet18约1.2%~1.8%,且略低于教师模型约0.1%~2%。这是正常现象,因为“更深更宽”的神经网络相比浅层神经网络具有更强的特征学习能力。此外,观察D-MSCNet和CenterNet的对比实验可知,在使用相同主干网络(MSA-ResNet18、MSA-ResNet50)的情况下,D-MSCNet不但能够在各项检测精度指标上优于CenterNet约1.3%~6%,而且能够保证几乎不增加参数量、计算量和降低检测速度。这不但验证了本文所提检测方法的优越性,也验证了所提蒸馏策略的有效性。

2.5 轮对踏面缺陷检测结果可视化分析

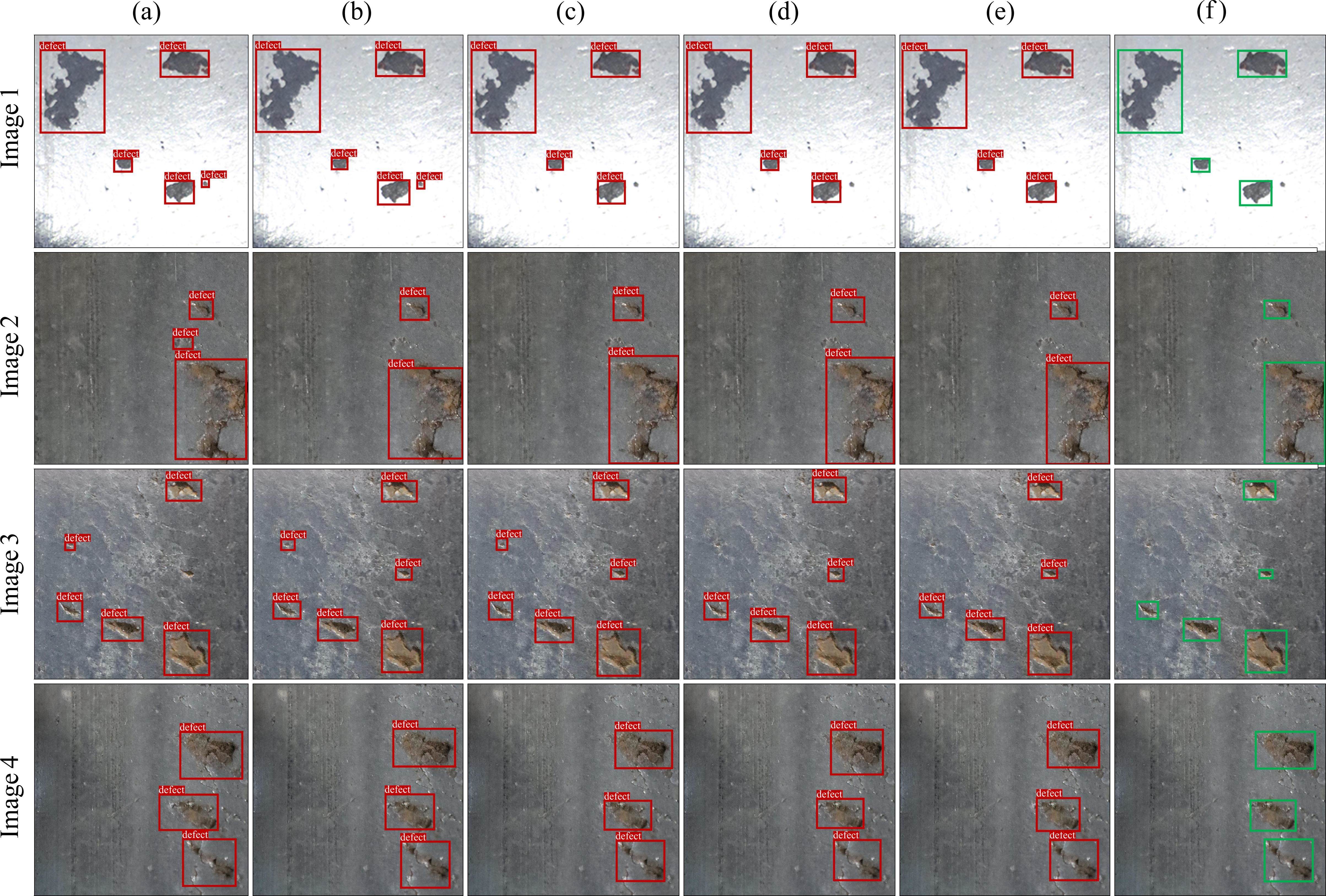

为了更加直观地观察模型的检测效果,本节对部分综合性能较好的对比方法进行了可视化实验,可视化结果如图7所示。其中,标识(a)~(f)分别表示YOLOv3、FCOS、Cascade-RCNN、DETR、D-MSCNet和真实标签。

从图7中的检测结果可以看出,方法(d)和(e)可以准确地检测出4幅图像中的缺陷,并且方法(e)的预测边界框比方法(d)更加紧凑和准确。然而,在其他对比实验中存在一些误检和漏检问题:1) 方法(a)在图像1、图像2和图像3中存在误检和漏检问题;2) 方法(b)在图像1和图像3中显示出误检现象;3) 方法(c)在图像3中存在误检的问题。值得注意的是,漏检和误检问题主要出现在图1和图3中。本文认为这是正常现象,因为图像1和图像3存在以下2种状况:1) 缺陷分布更加复杂且存在明显的尺度差异;2) 图像中的背景干扰更加严重。最后,由可视化结果可以看出,所提的D-MSCNet相较于其他对比方法能够更加精确地定位缺陷。这进一步验证了所提轮对踏面缺陷检测方法的优越性和有效性。

2.6 知识蒸馏策略实验分析

本文将知识蒸馏定义为不同教师网络和学生网络的回归分支间的信息交互,具体而言是在D-MSCNet中设计一种主从区域知识蒸馏策略用于知识转移。通过这种方式,能够在不增加模型复杂性和参数量的情况下提高轻量化学生模型的性能。为了验证该蒸馏策略的有效性,设置了以下实验以进行分析。

2.6.1 蒸馏损失调节因子影响分析

由公式(11)和公式(12)可知,蒸馏损失中存在2个待设计的超参数,即Generalized Softmax函数中的温度调节因子τ和次级蒸馏区域的程度调节因子γ。为此,本节在表4和表5中对2种超参数进行了分析。

| τ | MAP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% |

|---|---|---|---|---|---|---|

| ― | 64.7 | 96 | 77.4 | 60.8 | 68 | 66.4 |

| 1 | 65.1 | 96.2 | 77.6 | 60.7 | 67.2 | 66.2 |

| 5 | 65.8 | 96.6 | 77.8 | 61.3 | 69.4 | 67.8 |

| 10 | 66.2 | 97 | 78.8 | 62.5 | 69 | 68.4 |

| 15 | 66.2 | 96.4 | 78.4 | 61.8 | 67.8 | 68.8 |

| 20 | 65 | 96.2 | 78 | 62.5 | 67.4 | 68.4 |

| γ | MAP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% |

|---|---|---|---|---|---|---|

| 1 | 64.9 | 96.2 | 77.6 | 61.4 | 67.7 | 66.8 |

| 0.75 | 65.3 | 96.4 | 78.2 | 61.4 | 68.1 | 66.6 |

| 0.5 | 66 | 96.8 | 78.8 | 62.7 | 69.3 | 67.7 |

| 0.25 | 66.2 | 97 | 78.8 | 62.5 | 69 | 68.4 |

| 0 | 64.3 | 96.2 | 77.4 | 58.8 | 66.3 | 66.2 |

表4显示,当温度τ设置为10时,对学生模型的知识蒸馏效果最佳。然而,当舍弃Generalized SoftMax函数时,模型的检测性能相较于τ=10的情况降低了约1%~2%。这意味着利用Generalized SoftMax函数将回归分数转换为概率分布可以有效提高蒸馏效率。表5实验结果表明,当次级蒸馏区域调整因子γ被设置为0.25时,模型的精馏效果最为优化。然而,当不考虑二次蒸馏区域时(即γ=0),模型的蒸馏效果下降约0.8%~3.7%。这意味着在蒸馏过程中引入二次蒸馏区域可以提高蒸馏效率,也验证了本文提出的蒸馏方法的有效性。

2.6.2 蒸馏损失组成分析

为了验证所提蒸馏方法中主从蒸馏区域对于知识迁移的贡献度,本节进行了蒸馏损失的区域成分分析实验,结果如表6所示。其中,由公式(11)可知当λ1=0时,D-MSCNet中主区域蒸馏损失部分失效;当λ2=0时,次级区域蒸馏损失部分失效。因此,本实验主要通过控制λ1、λ2的数值来实现蒸馏损失的组件消融。此外,实验中的学生网络皆采用加载MSA-ResNet50的CenterNet检测器。

| λ1=0 | λ2=0 | MAP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% |

|---|---|---|---|---|---|---|---|

| √ | 64.9 | 96.1 | 76.8 | 59.6 | 65.9 | 65.7 | |

| √ | 65.3 | 96.4 | 77.2 | 61.2 | 67.9 | 67.2 | |

| √ | √ | 66.2 | 97 | 78.8 | 62.5 | 69 | 68.4 |

由表6中的实验结果可知,单一主蒸馏区域蒸馏所对应的模型各项检测性能优于仅在次级区域蒸馏时的模型性能约0.3%~2%。当同时在2个区域进行蒸馏时的模型性能最佳,优于单一区域蒸馏情况约0.6%~3.1%。由此可见,所设计的主从区域知识策略能够有效地提升知识蒸馏的效率。

2.6.3 知识蒸馏方法对比实验

为了进一步验证所提出的蒸馏方法的优越性,本文将之与一些经典的蒸馏方法进行了实验对比,实验结果如表7所示。

从表7的结果可以看出,本文方法在MAP、AP50、APs和APl 指标上表现最优,分别为66.2%、97%、62.8%和68.4%。具体来说,所提方法在各项性能指标上优于Fine-Grained、Defeat和LD loss约0.3%~2.3%,而仅在AP75和APm上劣于GI Imitation。这说明所提出的方法在综合性能指标上比基于特征图的蒸馏方法(GI Imitation、Fine-Grained和Defeat)和基于检测头的蒸馏方法(LD loss)具有更好的蒸馏效果。

2.7 主干网络特征提取性能实验

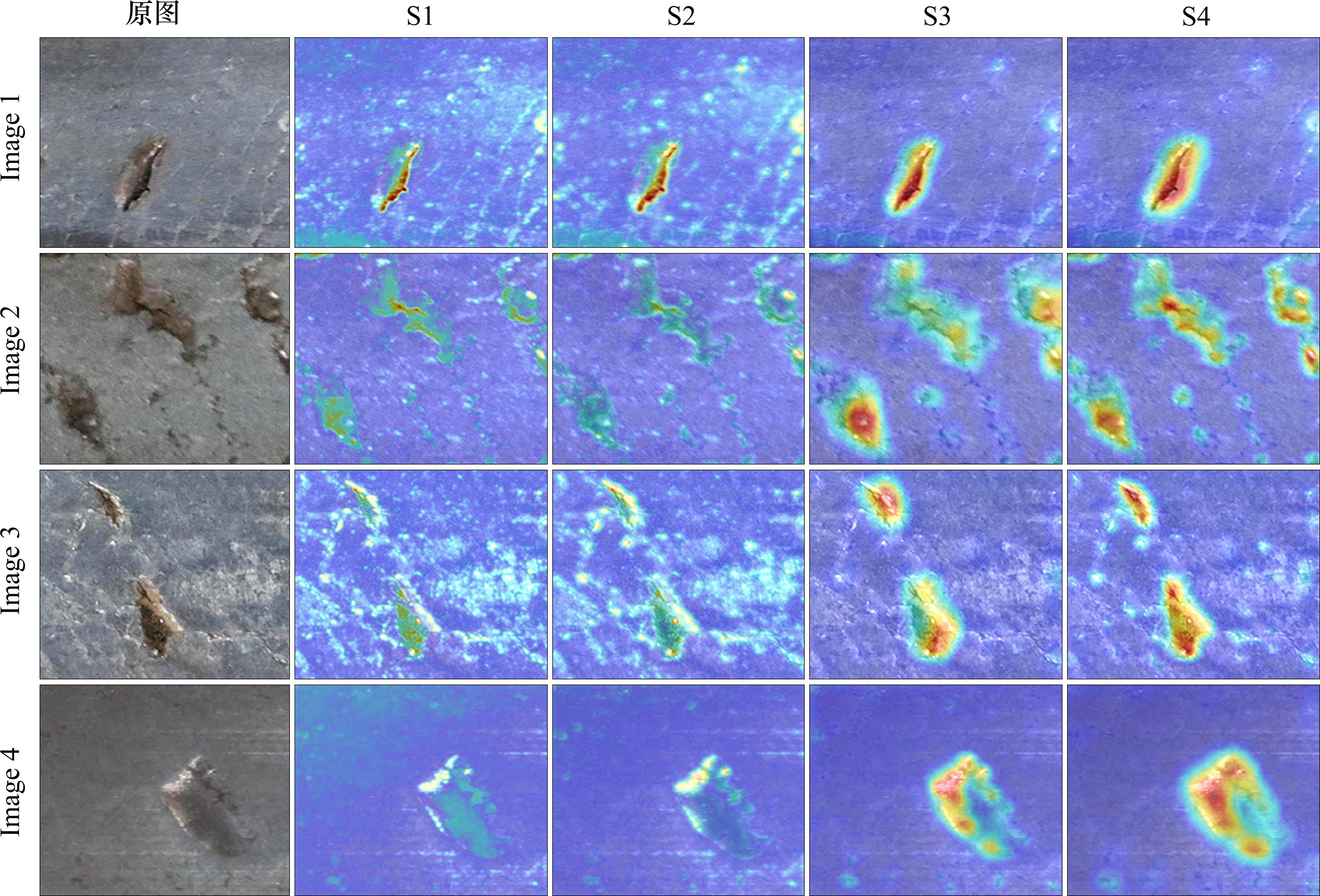

2.7.1 下采样过程特征图可视化分析

为更加直观地验证CSEM模块和MSDM 模块在MSA-ResNet前向过程中的特征提取效果,本文对每个MSA-ResNet中各Stage的输出进行了热力图分析。实验随机选取了4张缺陷图像输入训练好的网络中,图8展示了在前向传递过程中网络对缺陷图像不同区域特征的关注情况。颜色越红的区域表示网络对该区域的特征更加关注。其中S1-S4表示主干网络中4个Stage步。

2.7.2 多尺度下采样模块对比实验分析

此外,为了验证多尺度下采样模块 MSDM的优越性,本节将之与ASPP、DASPP以及Inception等经典多尺度方法进行对比,实验结果如表8所示。

由表8实验结果可知,本文所提的MSDM模块在所有对比方法中综合性能最优,而Inception、DASPP和ASPP模块的综合性能依次降低。在MAP、AP50、APm和APl等检测精度指标上,MSDM相较于ASPP、DASPP和Inception等方法分别具有0.7%~2.1%、1%~3%、1.8%~3.1%和1.4%~3.1%的优势。由此可见,本文所提的多尺度下采样模块MSDM相较于其他多尺度对比方法具有一定的优越性。

2.7.3 主干网络增量实验分析

最后,为了进一步探究CSEM和MSDM对于MSA-ResNet的影响,设计了对于主干网络的增量分析实验,实验结果如表9所示。其中,Baseline模型为以ResNet101为主干的CenterNet检测器;+CSEM为采用CSEM代替原始的瓶颈模块;+MSDM为采用MSDM代替原始的下采样卷积。

| Method | MAP/ % | AP50/ % | AP75/ % | APs/ % | APm/ % | APl/ % |

|---|---|---|---|---|---|---|

| (CenterNet) | 63.8 | 95.9 | 76.3 | 58.8 | 67.6 | 67 |

| +CSEM | 65.7 | 96.5 | 77.4 | 61.5 | 69.2 | 67.4 |

| +MSDM | 65.3 | 96.2 | 76.8 | 59.5 | 68.1 | 68.6 |

| +CSEM&MSDM | 66.3 | 97.3 | 79.2 | 63 | 71 | 69.3 |

表9的结果表明,当基线模型中加入CSEM时,模型性能提高了约0.4%~2.7%。当基线模型采用MSDM时,模型的综合性能提高了约0.3%~1.5%。由此可见,CSEM对模型的优化效果要大于MSDM。本文认为这是合理现象,因为在主干网络中CSEM的规模数量要大于CSEM。当模型中同时采用CSEM和MSDM时,模型的性能显著地提升了约1.4%~4.2%,上述实验进一步证明了本文对主干网络的改进是有效的。

2.8 泛化性能实验分析

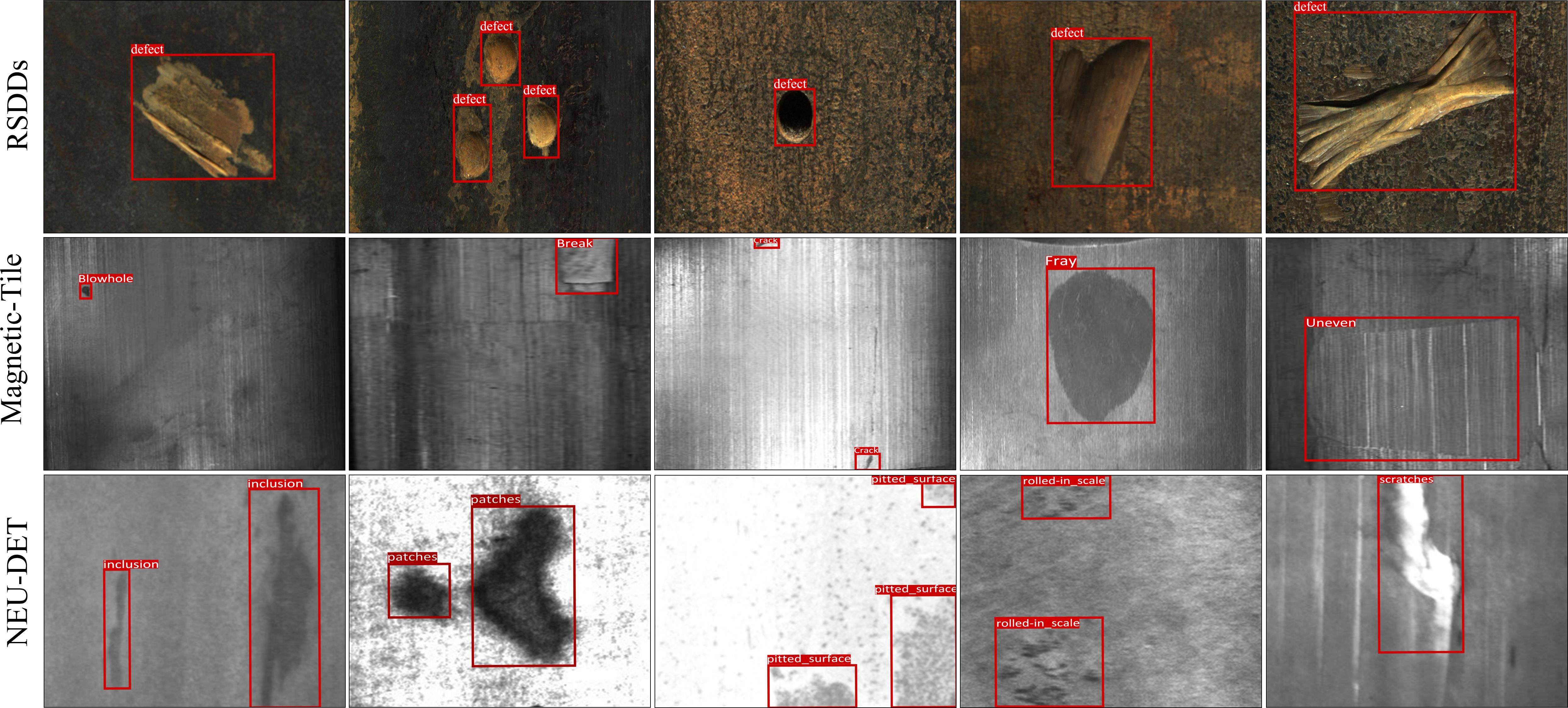

为了进一步验证模型的有效性,本文设置了泛化实验分析。所有实验皆采用主干为MSA-ResNet101的D-MSCNet为教师网络,并以主干为MSA-ResNet50的检测器作为学生网络。此外,为了更贴近研究内容,本文使用了公共工业表面缺陷数据集(NEU-DET[26]、NEU-RSDD-1[27]、Magnetic-Tile[28])作为实验对象。其中,泛化性能实验结果如图9所示。

由图9的可视化结果可以看出,所提方法在NEU-DET、Magnetic-Tile和RSDDs数据集上不但能准确定位各种表面缺陷,还能准确地识别出缺陷的类型。此外,为了进一步验证其泛化性能,本文进行了所提方法在3种数据集上的定量指标,结果如表10所示。

| Method | MAP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% |

|---|---|---|---|---|---|---|

| NEU-DET | 68.5 | 95.5 | 82.4 | 61.9 | 68.2 | 79.9 |

| Magnetic-Tile | 64.4 | 94.6 | 77.6 | 56.8 | 64.5 | 76.7 |

| RSDDs | 68.6 | 96.6 | 82.3 | 64.5 | 70.2 | 81.5 |

根据表10的结果可知,所提出的方法在NEU-DET、Magnetic-Tile和RSDDs数据集上分别可以实现68.5%、64.4%和68.6%的MAP,并且综合指标性能良好。这意味着所提出的方法具有良好的泛化性能,可以有效地应用于其他目标检测数据集。

3 结论

综上所述,为了提高CenterNet检测器对于具有多尺度、复杂背景以及低算力要求的列车轮对踏面缺陷的检测效果,本文提出一种新的D-MSCNet检测器。在该方法中,首先设计了一种新的跨层可分离特征提取模块(CSEM)来替代ResNet中的Bottleneck模块以在不显著增加计算量的情况下扩大模型感受野;其次,设计了一种具有多尺度架构和注意力机制的多尺度可分离下采样模块(MSDM)来替代ResNet中的下采样卷积以增强多尺度、关键缺陷特征的提取能力并弱化复杂背景特征;然后,为了进一步压缩模型以满足工业缺陷检测低算力、快速的要求,设计了一种根据Ground Truth分配蒸馏域的主从区域知识蒸馏策略;最后,使用列车轮对踏面缺陷数据集对模型进行了一些实验验证,并取得了一些积极的测试结果,得出如下结论:

1) 由对比实验的实验结果可知,在加载轻量级主干网络MSA-ResNet18时,D-MSCNet的MAP优于其他对比方法约1.1%~4.4%。

2) 与GI Imitation、Fine Grained、Defeat和LD等知识蒸馏方法相比,本文所提的主从区域知识蒸馏策略在综合检测指标上具有优势。

3) 相较于SE、DA和CBAM等注意力机制,当MSDM采用ECA作为注意力模块时,模型在MAP、AP50、AP75和APm指标上实现最优。

4) 由泛化性能实验结果可知,D-MSCNet在 NUE-DET、RSDD和Magnetic-Tile等公开表面缺陷数据集上仍然表现良好。

Distilling the knowledge in a neural network

[EB/OL]. 2015: arXiv: 1503.02531. http://arxiv.org/abs/1503.02531.程翔,朱禹熹,贾林.基于多尺度可分离蒸馏网络的列车轮对踏面缺陷检测算法[J].铁道科学与工程学报,2024,21(11):4789-4803.

CHENG Xiang,ZHU Yuxi,JIA Lin.Train wheel tread defect detection algorithm based on multi-scale separable distillation network[J].Journal of Railway Science and Engineering,2024,21(11):4789-4803.