我国高速铁路运营里程已达4.2万km[1],随着高铁路网的快速扩张、运输规模的持续扩大,运行时速的不断提升,高速铁路安全工作面临的形势日趋严峻和复杂。高速铁路虽采用全封闭管理,但人员入侵铁路运行环境的情况仍时有发生,人员一旦入侵高速铁路运行环境,会严重干扰运输秩序,造成大面积晚点,危害人民群众的生命财产安全。因此,对人员入侵铁路运行环境进行监测十分重要。最初,铁路安全监测主要采用人工巡查的方式,这种方法需要消耗大量人力,并且安保人员的注意力无法全天候集中,这种方法无法有效保障铁路运行环境的安全[2]。随着监控设备和网络传输技术的普及,安保人员在监控室查看铁路沿线布设的摄像头已经成为目前主流的安全监测方式,由于人眼在疲劳后工作效率会显著下降,这种监测方法仍存在一定的安全隐患。随着云计算、大数据、人工智能技术的成熟,通过对铁路沿线摄像头中获取的视频图像进行分析检测[3],自动排查线路安全情况,再实时将危情上报逐渐成为更高效的铁路安全问题的监测方式。基于深度学习的目标检测算法通过卷积神经网络对图像进行分析和处理,能够实现对人员入侵铁路运行环境的实时检测。基于图像的目标检测算法可分为双阶段(two-stage)检测算法和单阶段(one-stage)检测算法。双阶段检测算法将检测问题划分为2个阶段,首先产生候选区域,然后对候选区域进行分类和位置回归,双阶段检测算法识别准确率高,但速度较慢[4]。双阶段检测算法包括Fast R-CNN、Faster R-CNN等[5]。单阶段检测算法不需要产生候选区域阶段,直接生成目标的类别概率和位置坐标值,经过单次检测即可直接得到最终的检测结果,因此有着更快的检测速度。单阶段检测算法包括SSD算法、YOLO系列算法等[6]。由于对铁路人员入侵检测的实时性要求很高,故多采用单阶段检测算法进行检测,以保证检测速度。目前,学者们研究了基于视频图像的人员检测算法。李霄峰[7]通过融合运动分支和目标分支,降低了模型的误报率。张永强等[8]通过使用ResNet50代替原有的CSPDarknet53改进YOLOv4模型,提高了人员检测的准确率及检测速度。师后勤等[9]将注意力机制和Retinex图像增强算法融入到YOLOv3网络,提高了低光照下的人员检测效果。马志钢等[10]通过在主干网络和颈部网络中加入注意力机制,提升了网络的特征融合能力。综上,基于视频图像的目标检测算法已有一定的应用,但是,铁路人员入侵存在大量小目标成像的情况,目前已有的研究对远距离小目标检测还不够充分,如何提高对小目标检测的准确率,减低误报率,还有待进一步的研究。针对上述问题,本文以YOLOv8算法为基础,在网络结构中加入坐标注意力,引入动态检测头,使用Wise-IoU作为损失函数,进一步提升了模型的准确率,主要包括以下工作。

1) 在Backbone层加入坐标注意力机制,坐标注意力可以有效地提取小目标特征,提高模型对重要特征的关注程度。

2) 在Head层中使用将尺寸感知,空间感知和任务感知嵌入至一个检测头的动态检测头,提升模型对小目标的感知能力。

3) 使用Wise-IoU损失函数,Wise-IoU可以加快模型的收敛速度,减轻低质量样本产生的不利梯度影响,提升模型的泛化能力。

4) 整理数据集,实验验证改进模型在数据集上的效果,并与其他先进的检测模型进行对比,得出结论。

1 YOLOv8算法

YOLOv8是Ultralytics在2023年提出的最新YOLO系列检测模型。YOLOv8有n、s、m、l、x共5种不同大小的模型,不同大小模型的运行速度及参数量如表1所示。从表1可知,YOLOv8n是最小模型,有最快的检测速度和最小的参数量,由于铁路人员入侵检测对实时性要求很高,故选取YOLOv8n作为基础模型。

| 名称 | CPU下运行 速度/ms | GPU下运行 速度/ms | 参数量/M |

|---|---|---|---|

| YOLOv8n | 80.4 | 0.99 | 3.2 |

| YOLOv8s | 128.4 | 1.20 | 11.2 |

| YOLOv8m | 234.7 | 1.83 | 25.9 |

| YOLOv8l | 375.2 | 2.39 | 43.7 |

| YOLOv8x | 479.1 | 3.53 | 68.2 |

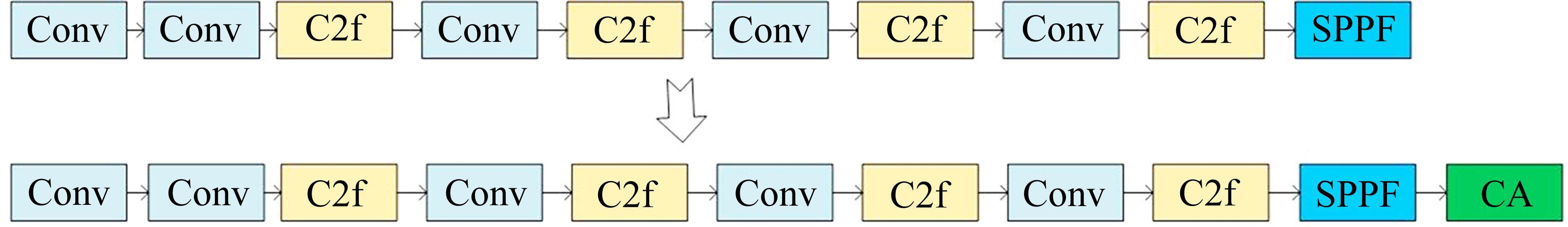

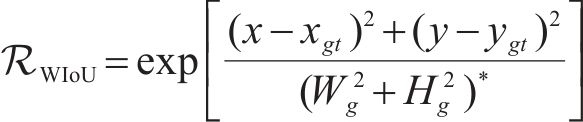

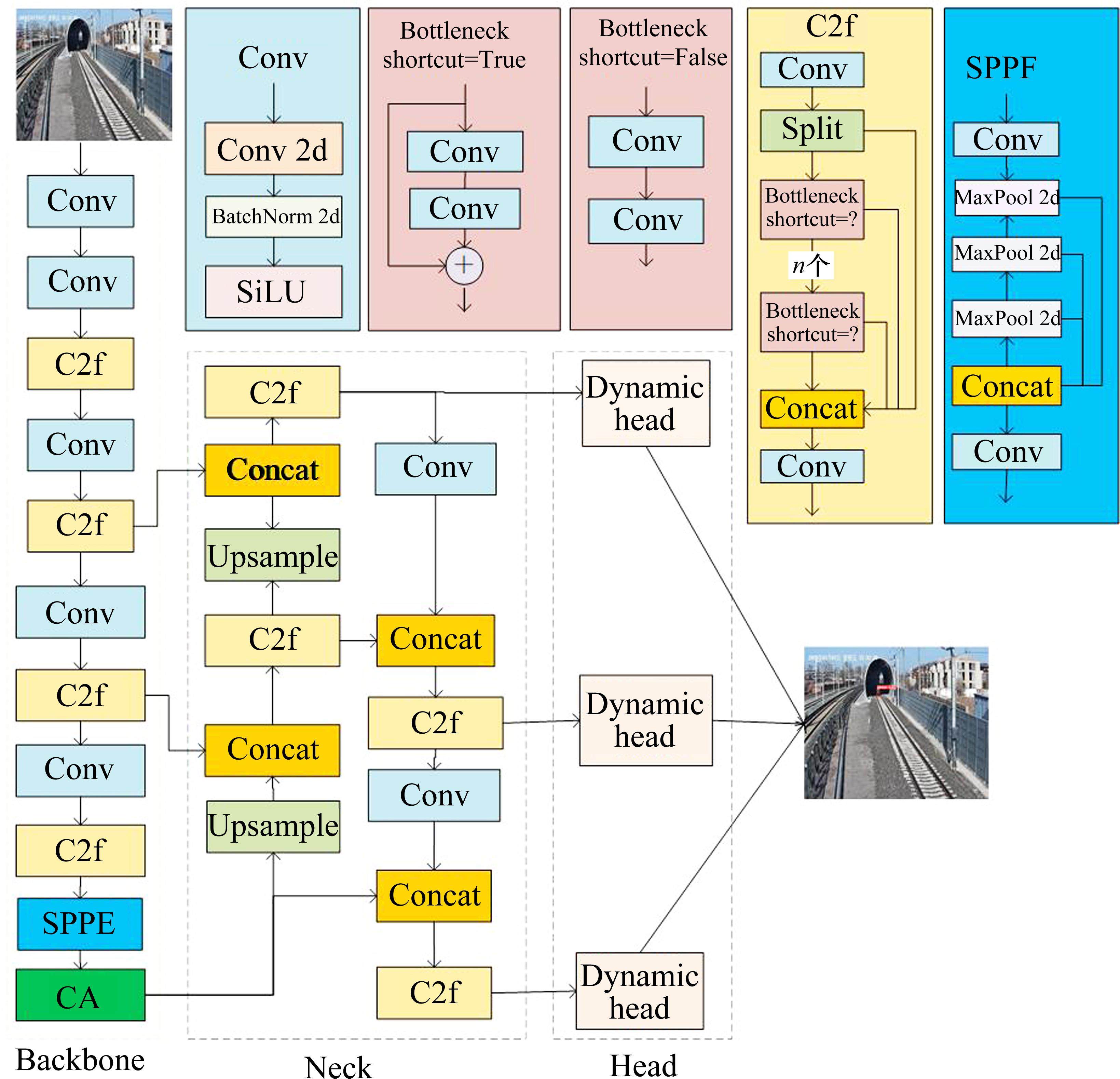

YOLOv8相较于之前版本的YOLO模型,具有更快的速度和更高的准确性,YOLOv8网络结构如图1所示,分为主干(Backbone)网络,颈部(Neck)网络以及检测头(Head),主干网络被用作特征提取,颈部和头部网络被用于定位和分类。在主干网络,相较于之前使用的C3模块,改为使用了C2f模块,并行更多梯度流分支,提高了网络的计算速度。在颈部网络,除了将C3改为C2f以外,还将上采样层前的卷积层删除。在检测头部分,由之前的耦合头改为解耦头结构,将分类任务和回归任务分离。同时,YOLOv8将之前的Anchor-Based换为Anchor-free,解决了之前模型计算量大的问题,并提高了模型的泛化能力。

2 YOLOv8n模型改进方法

2.1 坐标注意力

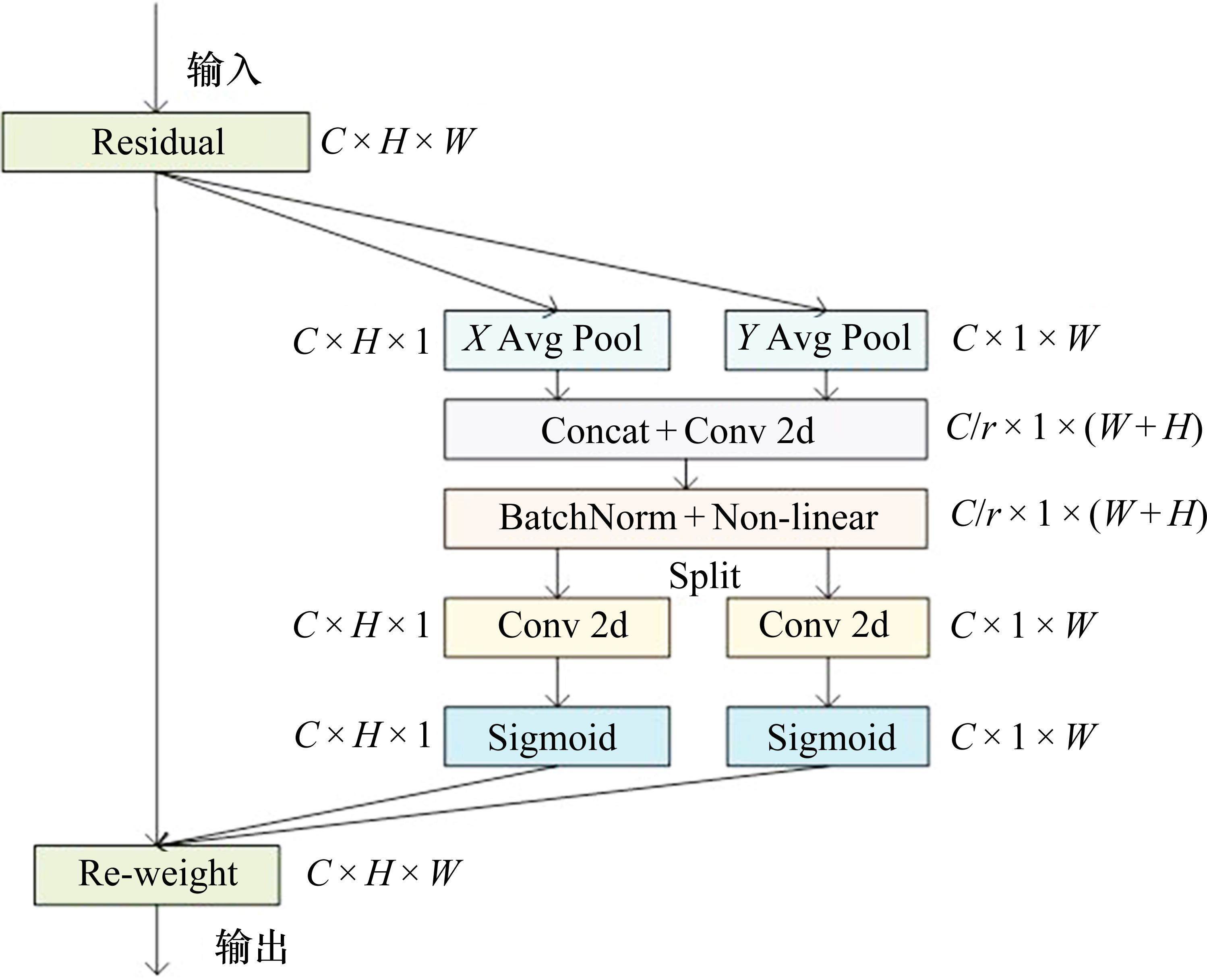

当有远距离目标入侵时,沿线摄像机获得小尺寸目标,在整个图像中占有较少的信息量,且分辨率较低,为提升模型对小目标的关注度,减少无关信息的干扰,本文在主干网络中加入坐标注意力(Coordinate Attention, CA)机制[11],通过赋予重要区域高权重来聚焦重要信息,以低权重忽略不相关的信息,在提取特征的同时,获取更精确的位置信息。坐标注意力的实现过程如图2所示。

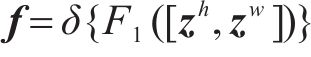

CA的实现过程如下:首先,将全局池化分解为2个一维的特征编码,对于每个输入尺寸为C×H×W的特征图X,分别沿水平和竖直方向对每个通道进行编码,得到高度和宽度2个方向的特征图[12],如式(1)和式(2)所示。

然后是坐标注意力生成的过程。将式(1)和式(2)得到的结果连接起来,把它们发送到卷积变换函数

得到

最后,将得到的

相较于传统的SE(Squeeze-and-Excitation)[15]注意力和BAM(Bottleneck Attention Module)[16]注意力在获取通道注意力的时候,一般使用最大池化或平均池化的方式,导致空间细节的丢失,CA注意力能够通过在高度和宽度上分别进行注意力计算,更精确地捕捉到图像在空间上的特征,更全面地获得特征间的依赖关系,从而精准地定位至入侵人员。

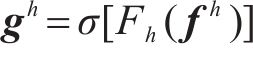

在Backbone网络SPPF层后加入CA层,使网络具有更好的检测特征能力的同时,对目标检测位置定位更加准确,提升网络的识别效果,加入CA后的YOLOv8n的Backbone部分网络结构如图3所示。

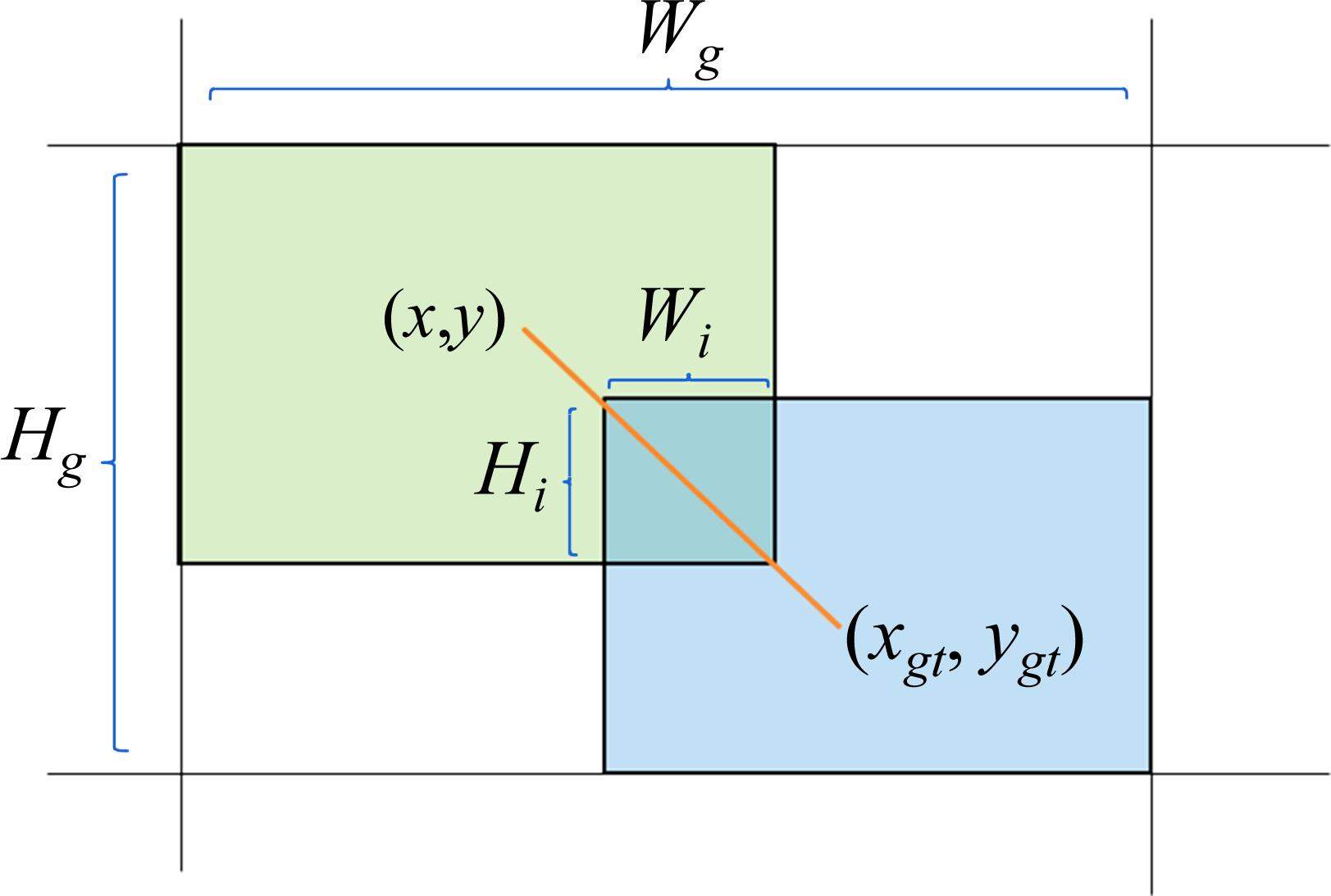

2.2 动态检测头

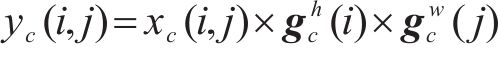

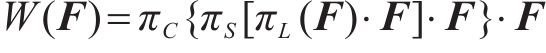

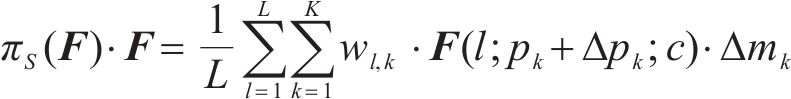

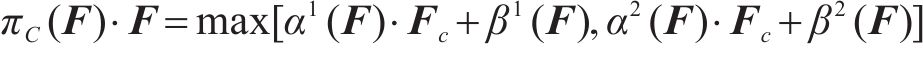

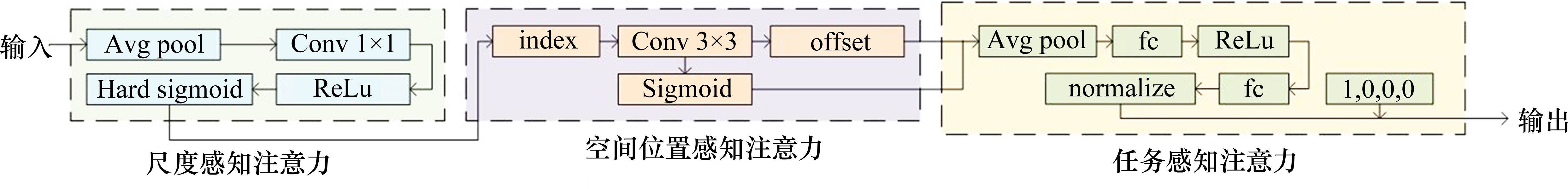

在铁路人员入侵检测的过程中,由于沿线摄像头分布情况不一,造成入侵目标尺寸差异较大,为更好融合目标特征尺寸的多样性,本文在Head网络中引入动态检测头(Dynamic head, Dyhead)[17]。Dyhead将尺寸感知,空间感知和任务感知结合起来,并将注意力机制分别部署在每个功能的特定维度上,最后嵌套为一个注意力函数,如式(7)所示。式中,

尺寸感知注意力根据不同尺寸的语义重要性动态融合目标特征,计算方式如式(8)所示。其中,

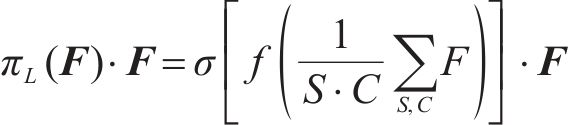

基于融合特征的空间感知注意力模块关注空间和特征存在一致的区域,计算方式如式(9)所示。

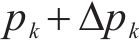

Dyhead通过任务感知注意力机制实现对不同目标的感知,通过动态开启和关闭通道来支持不同的任务。任务感知注意力机制的实现方法如式(10)所示,其中,

综上,Dyhead结构图如图4所示。通过多次嵌套Dyhead,将尺寸感知注意力、空间感知注意力、任务感知注意力叠加在一起,使模型实现更好的效果,在本文改进的YOLOv8模型中,将Dyhead嵌套次数设置为2,增强模型的检测能力。

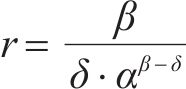

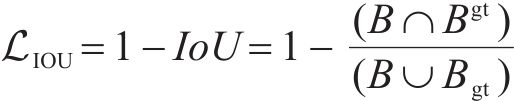

2.3 Wise-IoU损失函数

边界框回归(Bounding-Box Regression, BBR)损失函数的设计和模型的检测性能有直接的关系。YOLOv8n默认采用CIoU损失函数,CIoU将边界框的纵横比加入损失函数的量化标准,但使用了过多的复杂函数,在计算过程中消耗了大量算力,并且对于低质量标注框的回归仍然存在局限性。Wise-IOU是一种动态非单调调频损失函数[20],使用离群度(outlier degree)描述锚框的质量,离群度反映了锚框与真实目标之间的差异。对于低质量的锚框,降低其产生有害梯度的影响,从而降低对模型训练的干扰,提高模型对于复杂情况的适应能力,实现网络的动态聚焦学习,提升网络的泛化性能。Wise-IoU参数示意图如图5所示。

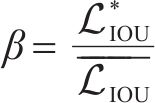

Wise-IoU实现方法如式(11)~式(15)所示[21]。在式(11)中,

经坐标注意力、动态检测头以及Wise-IoU损失函数改进后的YOLOv8n结构如图6所示。

3 实验及效果评价

3.1 数据集收集

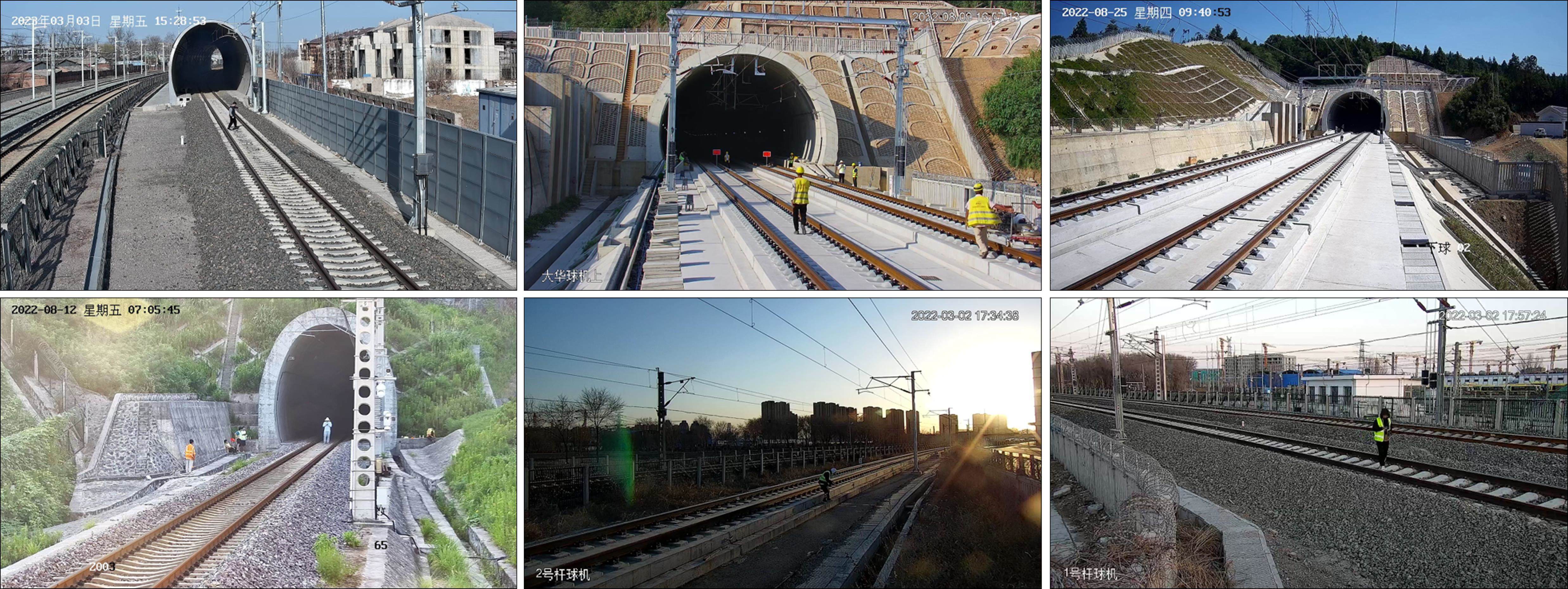

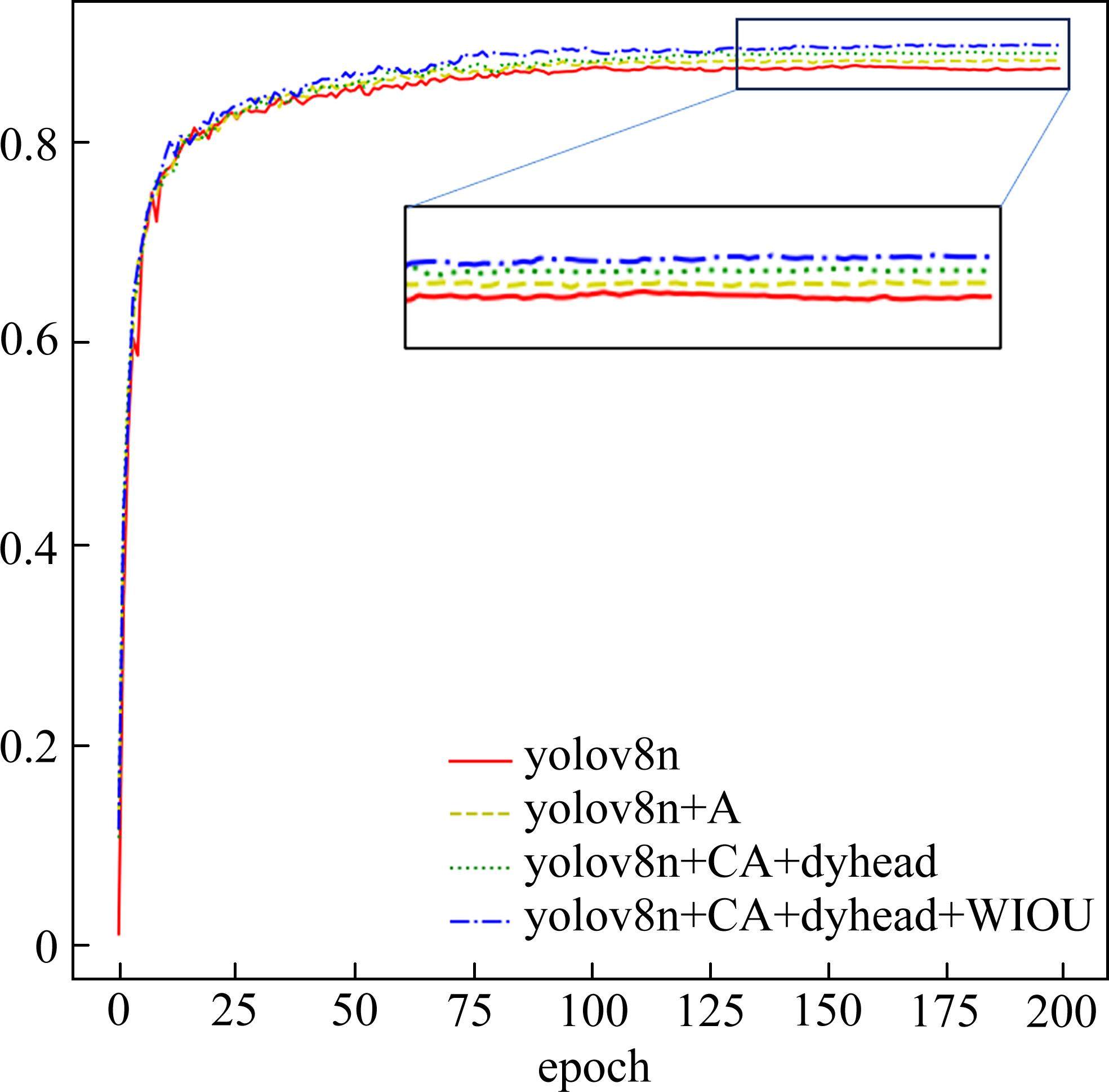

由于人员入侵的真实案例较少,故通过模拟入侵方式,记录样本并进行标注。人员入侵的场景包括隧道口,路基等铁路重点监测区域,在国家铁道试验中心及未投入使用的线路上进行模拟实验,模拟入侵场景如图7所示。

在收集到入侵样本后,将视频片段进行分帧,最后得到7 500余张图片,作为实验的数据集,其中,包括4 300余张照度较差的图片,5 000余张小目标入侵的图片。

3.2 实验环境

实验的操作系统版本为Linux Ubuntu 20.04.1,torch版本为2.0.1,python版本为3.9.17,GPU为GeForce RTX3090Ti×2,CPU为12th Gen Intel Core i9-12900K。将标注的图片按照9∶1的比例划分为训练集和验证集。每次训练的轮次为200,batch为16,工作线程为8,优化器选用SGD。

在实际部署中,常用方法为将检测模型部署在边缘计算设备中,接入沿线摄像机视频流进行实时检测。为探究本文改进模型在真实场景下的应用情况,将模型部署至边缘计算设备,探究模型在实际情况下的处理性能及效率。边缘计算设备的操作系统版本为Ubuntu 20.04,python版本3.8.10,GPU为NVIDIA Ampere architecture,CPU为12-core Arm Cortex-A78AE。

3.3 评价指标

在目标检测任务中,评价网络性能的指标主要有以下几种:精确率(precision, P)、召回率(recall, R)、平均精度(mean average precision, mAP)。精确率

召回率

将每个类别的准确率

本实验使用精确率Precision、召回率Recall、 mAP50、mAP50-95作为模型性能评价指标。mAP50代表IoU为0.5时,模型的平均检测精度。mAP50-95代表IoU在0.5~0.95,以0.05为步长,模型的平均检测精度[24]。除此之外,选用平均每秒检测帧数(Frames Per Second, FPS)作为衡量模型检测速度的指标。

3.4 消融实验结果

3.4.1 注意力改进效果实验

为探究不同注意力机制对模型改进效果的影响,本文将CA注意力机制与SE(squeeze-and-excitation)注意力机制、BRA(bi-level routing attention)注意力机制[25]、BAM(bottleneck attention module)注意力机制、EMA(efficient multi-scale attention)注意力机制[26]进行对比,基准模型为YOLOv8n,实验结果如表2所示,从表2可知,CA注意力机制的平均检测精度更高,有更好的检测效果。

| 模型 | mAP50 | mAP50-95 |

|---|---|---|

| YOLOv8n | 87.3 | 58.0 |

| YOLOv8n+CA | 88.2 | 58.1 |

| YOLOv8n+SE | 87.8 | 57.5 |

| YOLOv8n+BRA | 87.3 | 56.7 |

| YOLOv8n+BAM | 87.9 | 57.5 |

| YOLOv8n+EMA | 87.3 | 56.5 |

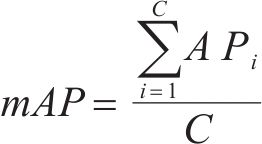

另外,本文还以热力图可视化的方式,选择远距离目标场景(图8(a)~图8(c))及多种距离目标场景(图8(d)~图8(f))探究了CA注意力机制及其他注意力的关注区域。原生YOLOv8n、CA注意力、SE注意力机制、BRA注意力机制、BAM注意力机制、EMA注意力机制热力图可视化结果如图8(a)~图8(f)所示,从图中可以看出,CA注意力热区集中在入侵人员上,对入侵人员的关注度更高,相比其他注意力有更好的效果。

3.4.2 Dyhead嵌套次数实验

Dyhead模块的嵌套次数将会直接影响模型的性能,本文对比了嵌套1~6次Dyhead模块对模型性能的影响,实验结果如表3所示,由于每次嵌套操作都会增加模型的复杂度,每多嵌套一次Dyhead,模型的参数量将会增加约0.5 M,并多付出约0.5GFLOPs的计算力,同时权重文件的大小也会增加约1 MB,故在综合考虑模型性能和复杂度后,本文将嵌套次数设置为2,实现检测精度和模型复杂度的平衡。

| Dyhead嵌套次数 | mAP50/% | mAP50-95/% | 参数量/M | GFLOPs | 权重文件大小/MB |

|---|---|---|---|---|---|

| 1 | 88.8 | 59.2 | 3.49 | 9.6 | 6.88 |

| 2 | 89.2 | 60.2 | 3.99 | 10.2 | 7.83 |

| 3 | 89.1 | 60.2 | 4.48 | 10.7 | 8.79 |

| 4 | 89.1 | 59.6 | 4.98 | 11.2 | 9.74 |

| 5 | 89.2 | 60.1 | 5.47 | 11.7 | 10.70 |

| 6 | 88.6 | 59.6 | 5.97 | 12.3 | 11.60 |

3.4.3 综合实验与对比结果

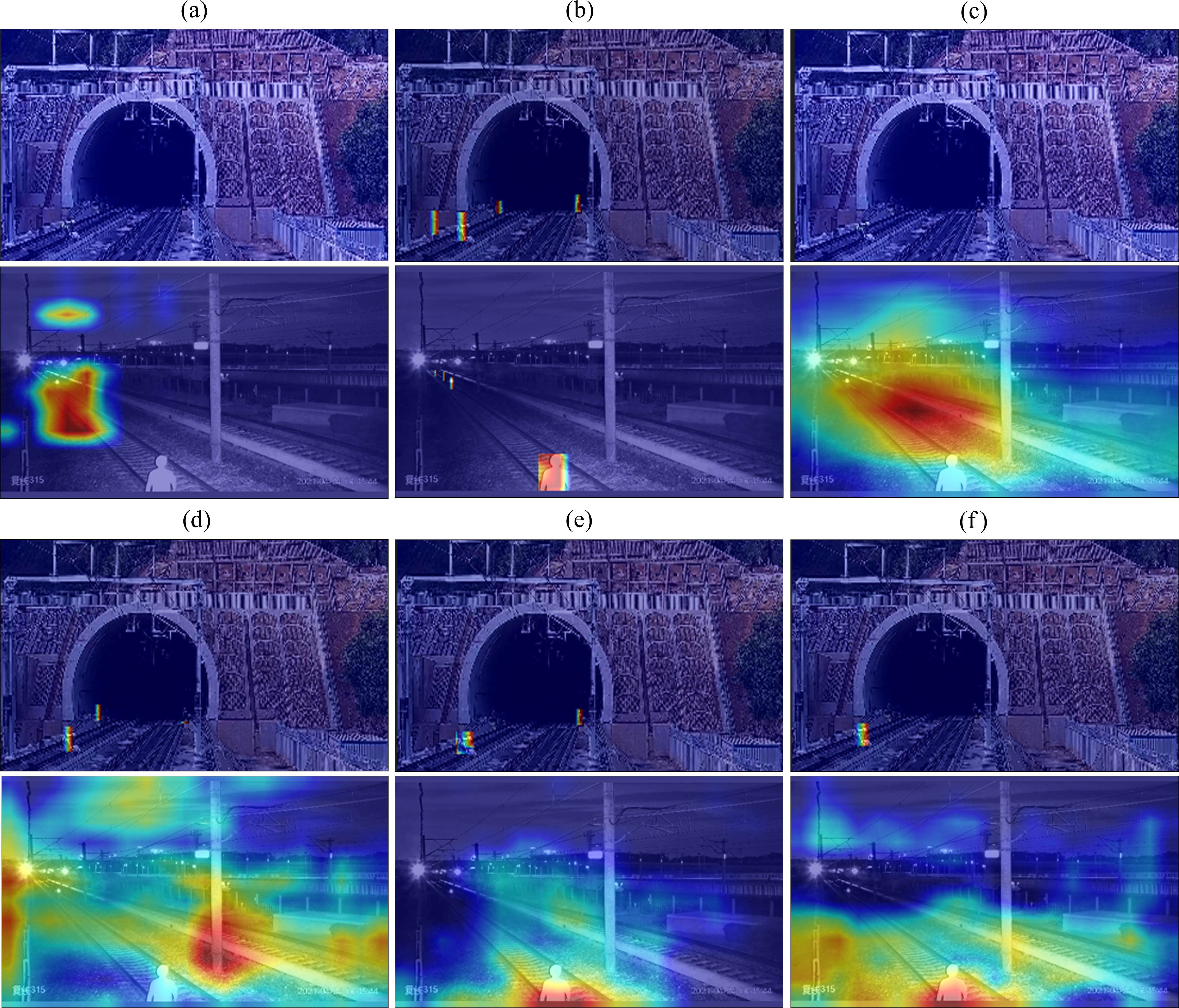

本实验在YOLOv8n基础上进行。优化1为在Backbone网络中加入CA注意力机制,优化2为在优化1的基础上,将检测头改为Dyhead检测头,优化3为在优化2的基础上,将损失函数改为Wise-IoU。所有实验均采用相同的训练参数,并在相同数据集上进行。训练时mAP50随训练轮数变化如图9所示,可以看出,训练轮次达到200轮时,模型均已收敛。

各改进消融实验结果如表4所示。从表4中可以得知,3种优化方法均提高了模型的检测效果,最终准确率从89.4%提升至91.6%,召回率从81.4%提升至83.7%,mAP50从87.3%提升至89.9%,mAP50-95从58.0%提升至60.9%。对比改进模型和原模型的FPS指标,改进模型的处理效率未显著下降,仍保持较好的处理速度。实验证明,改进方法能够在几乎不牺牲处理效率的情况下显著提升性能,可更好地应用于铁路人员入侵检测场景中。

| 试验方法 | CA注意力 | dyhead检测头 | WIoU损失函数 | Precision/% | Recall/% | mAP50/% | mAP50-95/% | FPS |

|---|---|---|---|---|---|---|---|---|

| YOLOv8n | 89.4 | 81.4 | 87.3 | 58.0 | 45.3 | |||

| 优化1 | √ | 90.3 | 81.7 | 88.2 | 58.1 | 44.6 | ||

| 优化2 | √ | √ | 91.6 | 81.9 | 89.2 | 60.2 | 42.5 | |

| 优化3 | √ | √ | √ | 91.6 | 83.7 | 89.9 | 60.9 | 43.7 |

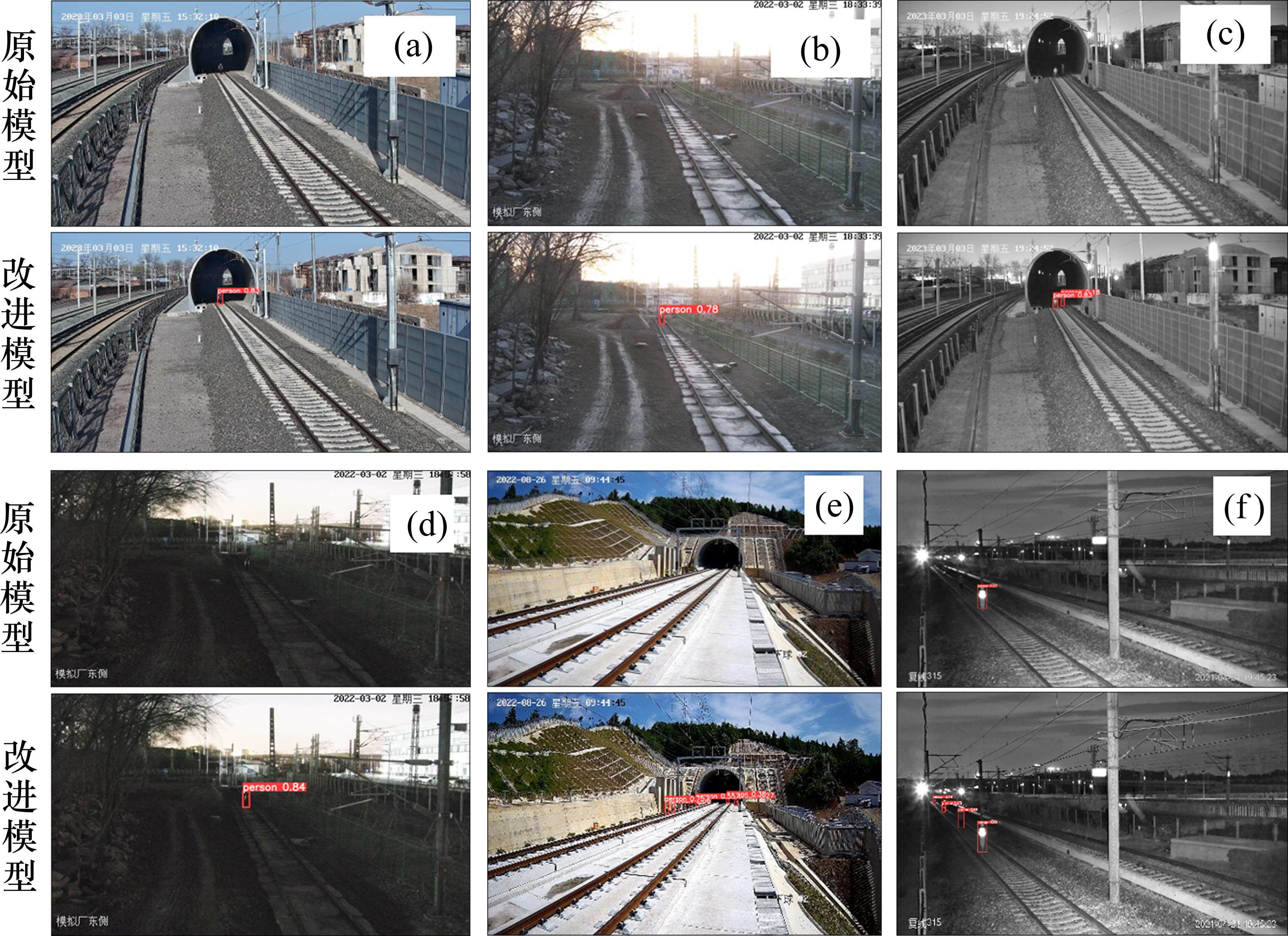

模型的检测效果对比如图10所示。图10(a)和图10(b)为照度较好的中远距离场景,改进模型能够检出入侵人员,原生YOLOv8n未检出。图10(c)和图10(d)为照度较差的中远距离场景,YOLOv8n未检出,改进模型能够检出。图10(e)为照度较好的多种距离入侵场景,YOLOv8n未能检出,改进模型将中距离的2人,远距离的3人全部检出。图10(f)为照度较差的多种距离入侵场景,YOLOv8n只检出距离最近的目标,改进模型将近、较近、较远、远的4个目标全部检出,对于较远的目标,有框识不准确的现象,对于最远的目标,置信度较低,模型仍需进一步优化。总体来说,改进模型在不同场景下的检测效果均有提高,误检、漏检情况降低,模型整体性能有所提升。

为进一步探究本文改进模型的性能,将改进模型与SSD、Faster R-CNN、YOLOv5、YOLOv6、YOLOv7等先进的目标检测模型对比,对比效果如表5所示,从表5可以看出,改进的YOLOv8n模型的平均精度高于其他先进的目标检测模型。进一步验证了改进模型的效果。

| 模型 | mAP50 | mAP50-95 |

|---|---|---|

| SSD | 58.8 | 24.6 |

| Faster R-CNN | 67.9 | 32.3 |

| YOLOv5n | 87.3 | 55.8 |

| YOLOv6n | 87.1 | 56.2 |

| YOLOv7-tiny | 86.2 | 50.5 |

| 改进的YOLOv8 | 89.9 | 60.9 |

4 结论

1) 为提升检测模型对小目标的检出能力,在YOLOv8网络中加入CA注意力机制,通过对特征图在坐标上进行加权,使模型可以更好地提取小目标特征;使用Dynamic Head检测头,通过多种感知机制,提高模型对不同尺寸目标的感知能力;改进Wise-IoU损失函数,使网络可以动态聚焦学习。实验结果表明,每种改进对模型性能均有提升,改进模型的准确率、召回率、mAP50、mAP50-95达到90.7%,83.7%,89.9%,60.9%。

2) 将改进模型与其他先进的目标检测方法进行对比,改进模型也有更高的平均精度。总体来说,本文提出的改进算法有效地提高了小目标人员入侵的检测效果,可更好地满足实际的应用需求。

BAM: bottleneck attention module

[EB/OL]. 2018: arXiv: 1807.06514. http://arxiv.org/abs/1807.06514.滑窗注意力多尺度均衡的密集行人检测算法

[EB/OL].基于DMSANet-YOLOv7的雾霾下绝缘子缺陷实时检测方法

[EB/OL].Wise-IoU: bounding box regression loss with dynamic focusing mechanism

[EB/OL]. 2023: arXiv: 2301.10051. http://arxiv.org/abs/2301.10051.基于DSCS-YOLO的苹果表面缺陷检测方法

[EB/OL]. http://kns.cnki.net/kcms/detail/32.1148.S.20231107.1546.002.html,吴浩楠,史宏,王瑞等.基于改进YOLO v8的铁路人员入侵检测方法研究[J].铁道科学与工程学报,2025,22(04):1828-1839.

WU Haonan,SHI Hong,WANG Rui,et al.Research on railway intrusion detection method based on improved YOLO v8[J].Journal of Railway Science and Engineering,2025,22(04):1828-1839.