我国已经成为世界上最大规模高速铁路运营国家,但是国内不同地区地理环境差异大、自然环境多样、气候条件复杂多变,山区铁路沿线遭遇强降雨、大风等恶劣气候或地质不稳定时,常发生岩石坠落、山体滑坡等自然灾害。在离居民居住区较近的区域,则易出现闲杂人员横穿铁路的情况。当这些崩塌落石或闲杂人员等侵入铁路限界时,无论是对铁路旅客的生命财产安全还是铁路的基础设施都会造成严重的危害。同时这些事件具有突发性,需要及时发现。但是目前主要的检测方式还是通过传统人工巡检,具有工作量大、发现不及时等诸多问题。所以利用其他技术手段对铁路异物侵限实时监测尤为重要。近年来,研究人员广泛研究图像处理技术与计算机技术的结合与应用,研究人员在现有的铁路视频综合监测系统中融入基于机器视觉的检测技术,使视频智能分析技术为铁路线路危情检测提供了可能。当前很多学者开展了异物入侵检测研究工作。传统方法大多采用背景建模,但该方法对噪声较为敏感,当背景中存在微小运动或干扰时,易出现误报情况,针对此类问题一些学者进行了相关研究。宁正等[1]提出一种异物入侵检测算法,该算法通过结合混合高斯背景建模和小波变换原理来解决传统混合高斯背景模型背景信息容易被污染和前景目标检测不完整的问题。王国屹等[2]通过速度信息辅助的位置插值,找到与待检测图像序列最为匹配的背景模板帧,之后算法将图像分割为多个子区域提取特征点后,与最匹配帧进行对齐差分以实现异物检测,有效减少误检和漏检的情况。王林峰等[3]为去除雾天对轨道异物检测造成的干扰,提出帧间差分优化检测方法,使用暗通道先验算法对图像进行去雾操作,通过在帧间差分算法中选取连续多帧得出各组插值的方法,提高轨道异物识别的准确率。ROMERO-GONZÁLEZ等[4]利用Gabor滤波器组捕获不同频率分量,通过统计矩量化纹理水平,从而准确区分前景和背景目标,解决了准确检测运动物体的难题。尽管相关研究提升了背景建模方法的性能,但与深度学习方法相比,仍在处理复杂场景和抗噪能力方面存在差距,深度学习算法从大量数据中学习复杂特征表示,捕捉更高级的语义特征,使得深度学习在复杂环境下表现更加鲁棒,更适用于铁路易受光照变化、风吹植被等因素干扰的检测场景。目前深度学习得到了广泛应用,相关目标检测的算法也有了诸多进展。在解决小尺度目标检测问题方面,余志强等[5]提出一种基于改进Faster RCNN的小尺度铁路侵限算法,通过融合深浅层特征、修改锚点框尺寸和数量的方法提高目标检测的识别精度,改善小尺度目标异物漏检问题。马静怡等[6]提出利用双线性插值法计算入侵目标体定位框的坐标,实现小尺寸异物像素级别的精确定位。朱力强等[7]提出多输入双输出神经网络和基于自适应特征加权融合的目标多尺度特征感知算法,解决铁路监控场景中入侵目标尺度变化的问题。MO等[8]将多注意力机制和双向特征金字塔集成到YOLOv5中,提高了模型从复杂背景中区分小规模异物的能力。TIAN等[9]采用BilDA融合不同卷积层的特征,使用空间金字塔池化模块融合不同感受野提取到的特征映射,提高多尺度异物检测准确度。在解决轻量化和实时检测方面,刘朝辉等[10]基于LR-ASPP提出一种轻量级分割模型分割轨道检测区域,基于YOLOX-S的模型使用深度可分离卷积降低模型复杂度识别轨道表面异物。王辉等[11]基于YOLOv3提出一种轨道侵限异物的快速检测方法,通过行锚框分割算法检测轨道线坐标位置,使用基于图像频率的双通道卷积进一步提升检测速度。姜香菊等[12]基于YOLOv8通过使用轻量化主干网络减小模型参数量和计算量,解决现有铁路异物入侵检测模型在边缘设备上无法保证实时检测的问题。在解决小样本目标准确率低的问题上,赵宗扬等[13]提出一种高鲁棒性多尺度小样本轨道入侵异物检测模型,设计小样本轨道入侵异物检测优化模块解决目标检测方法无法打破大数据驱动的训练壁垒、小样本目标检测在复杂轨道环境中检测能力差、鲁棒性低等问题。刘力等[14]在YOLOv4模型基础上,在骨干网络和特征融合网络之间加入压缩和激励模块,并改进K-mean使用欧氏距离选取聚类中心,解决传统检测方法只能检测单一侵限类别以及时效性不高的问题。徐鑫等[15]针对真实铁路入侵数据较少且难以获取的问题,通过模拟、真实采集、样本生成的方式,构建了10 000张铁路入侵数据集,并使用数据增强进一步扩充,最后通过目标检测模型对行人和动物进行检测。上述研究对铁路异物检测难点问题进行了针对性的改进,但大多聚焦于小目标或小样本问题的解决,未能充分考虑各问题之间的综合影响,进行多问题的联合解决。在实际铁路沿线环境中,存在环境复杂、小尺度目标、小样本目标准确率较低等问题,均为铁路异物入侵识别带来了挑战,单一技术方案难以满足复杂场景高精度、实时性和鲁棒性的要求,因此提出基于特征聚焦扩散网络的铁路异物入侵检测方法,通过轻量化主干网络结构降低计算消耗;提出特征聚焦扩散金字塔网络,提升不同尺度目标识别能力;通过动态检测头改善目标细粒度特征信息丢失问题;使用Focal-EIOU损失函数,提升小样本识别能力,以实现铁路异物入侵的有效识别。

1 基于特征聚焦扩散的铁路异物入侵动态检测网络

因实时性与网络带宽限制问题,本文算法应用于铁路沿线边缘计算设备中,为满足国产算能SE7边缘设备的算力限制,基于MLIR工具链,在BM1684X计算芯片上对YOLOv5、YOLOv8、YOLOv9、YOLOv10、YOLOv11进行mAP、Latency、Param、Flops等指标进行初步实验。经实验分析:在BM1684X-TPU芯片上完成模型迁移和算法适配后,M和L尺寸的模型能够保持较高的精度,但L尺寸的推理的时延较大,在M尺寸的模型中,YOLOv8m的Latency时延均低于YOLOv5m,YOLOv7m,YOLOv9m,YOLOv10m,YOLOv11m,综合推理精度和推理速度选择YOLOv8m作为本文的基准模型。

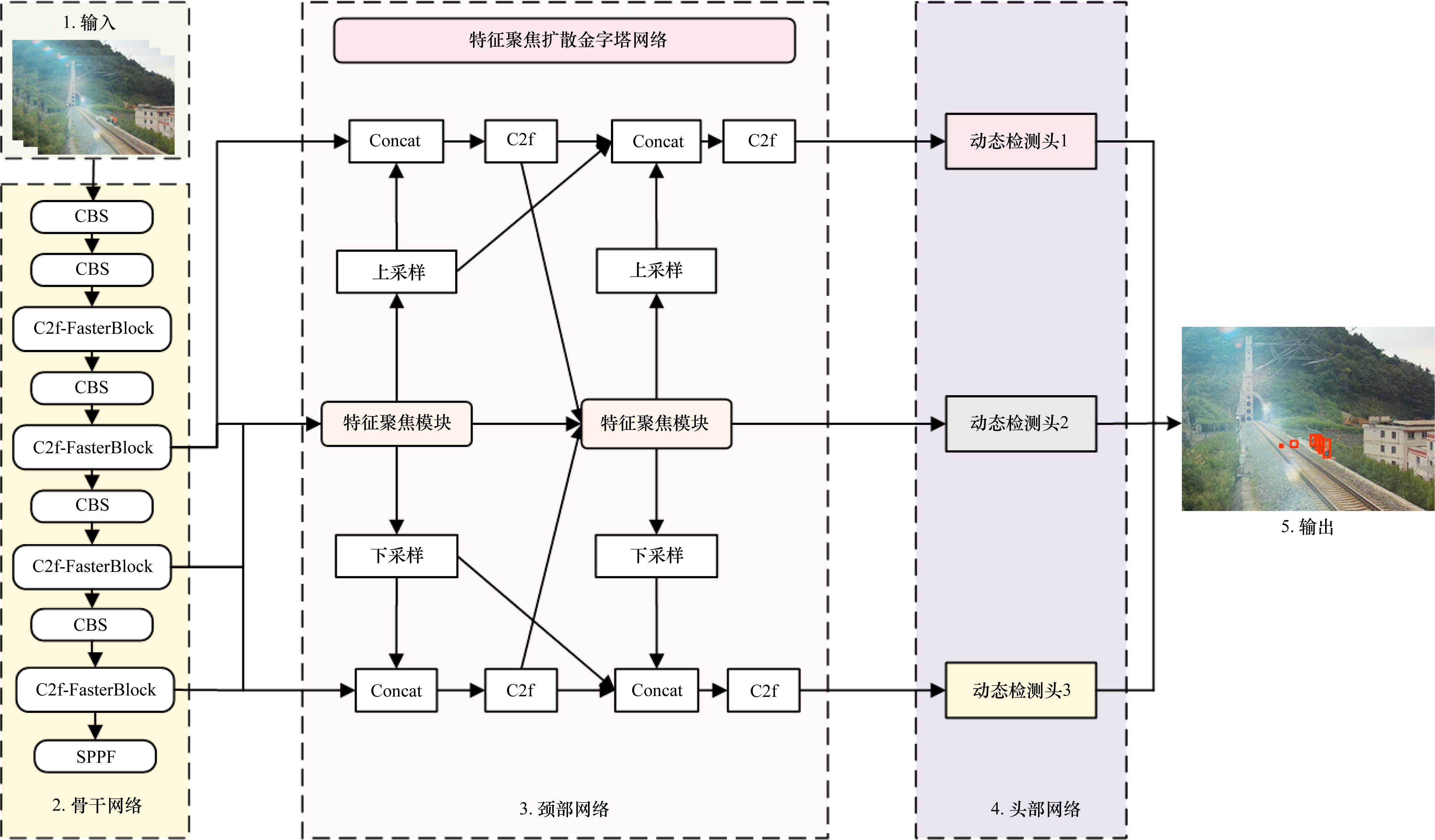

改进后的YOLOv8[16]网络结构如图1所示,其主要组成部分为骨干网络、颈部网络以及头部网络。

1.1 轻量化主干网络

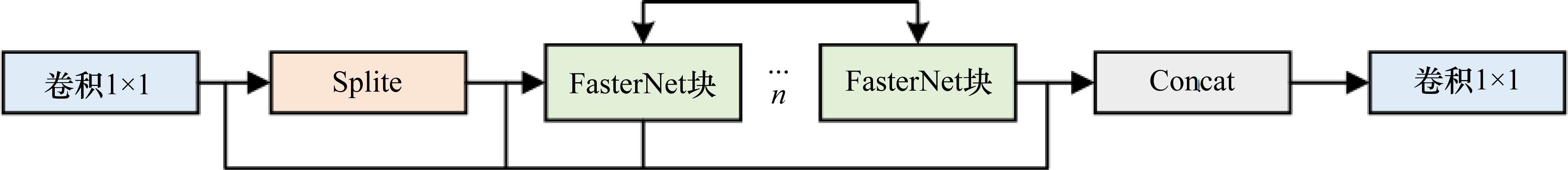

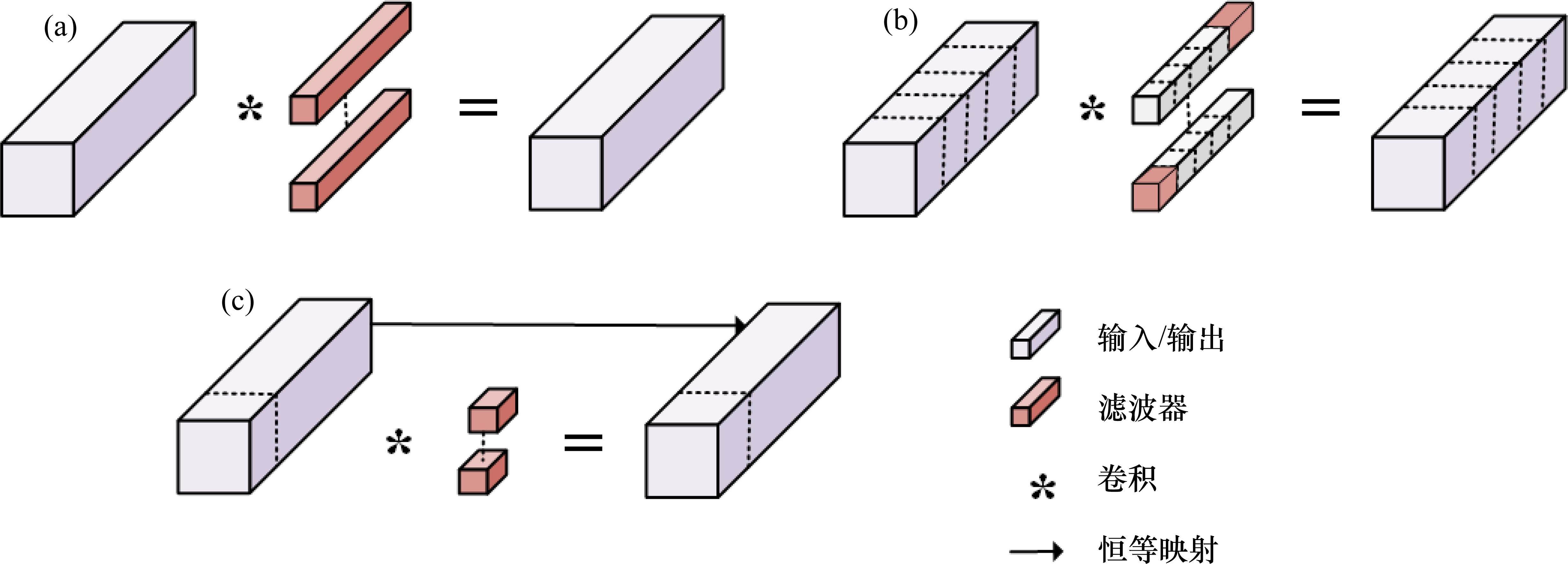

为了减少模型的参数量和计算量,满足算法实时分析需求,本文基于FasterNet的PConv卷积算子融合C2f算子构成新的C2f-FasterBlock模块。相较于原始YOLOv8m模型,改进后的模型在不影响精度情况下,让模型的计算量和参数量得到降低,加快了模型在边端计算设备上的推理速度。

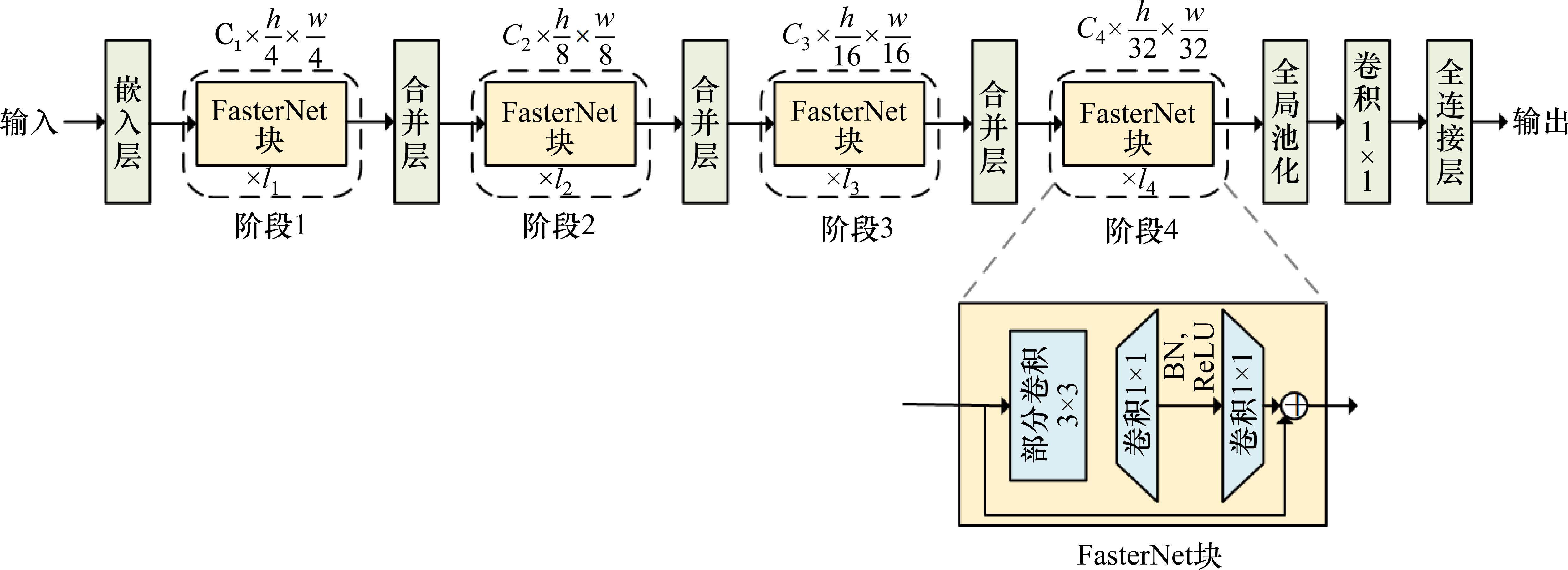

如图3所示,为FasterNet整体架构图。分为4个层次阶段,为增加通道数量以及对空间进行下采样,在第1个阶段前设置步长为4,大小为4×4卷积大小的嵌入层,在后3个阶段前设置步长为4,大小为4×4卷积大小的合并层。最后2个阶段中的FasterNet 块拥有更高的浮点运算,同时内存访问开销更低,所以在这2个阶段中配置了更多FasterNet块,并相应加大了对它们的计算资源分配。一个PConv层加上2个逐点卷积(Pointwise Conv, PWConv)或1×1大小的Conv层组成每个FasterNet块,并共同构成残差模块,通过设置快捷路径来复用输入的特征信息。

卷积操作(Conv)是现在许多网络模型的关键子模块。对于输入

PConv算子只应用常规卷积在一部分输入通道上进行空间特征提取,其余通道保持不变。因此,PConv的FLOPs值的大小仅为:

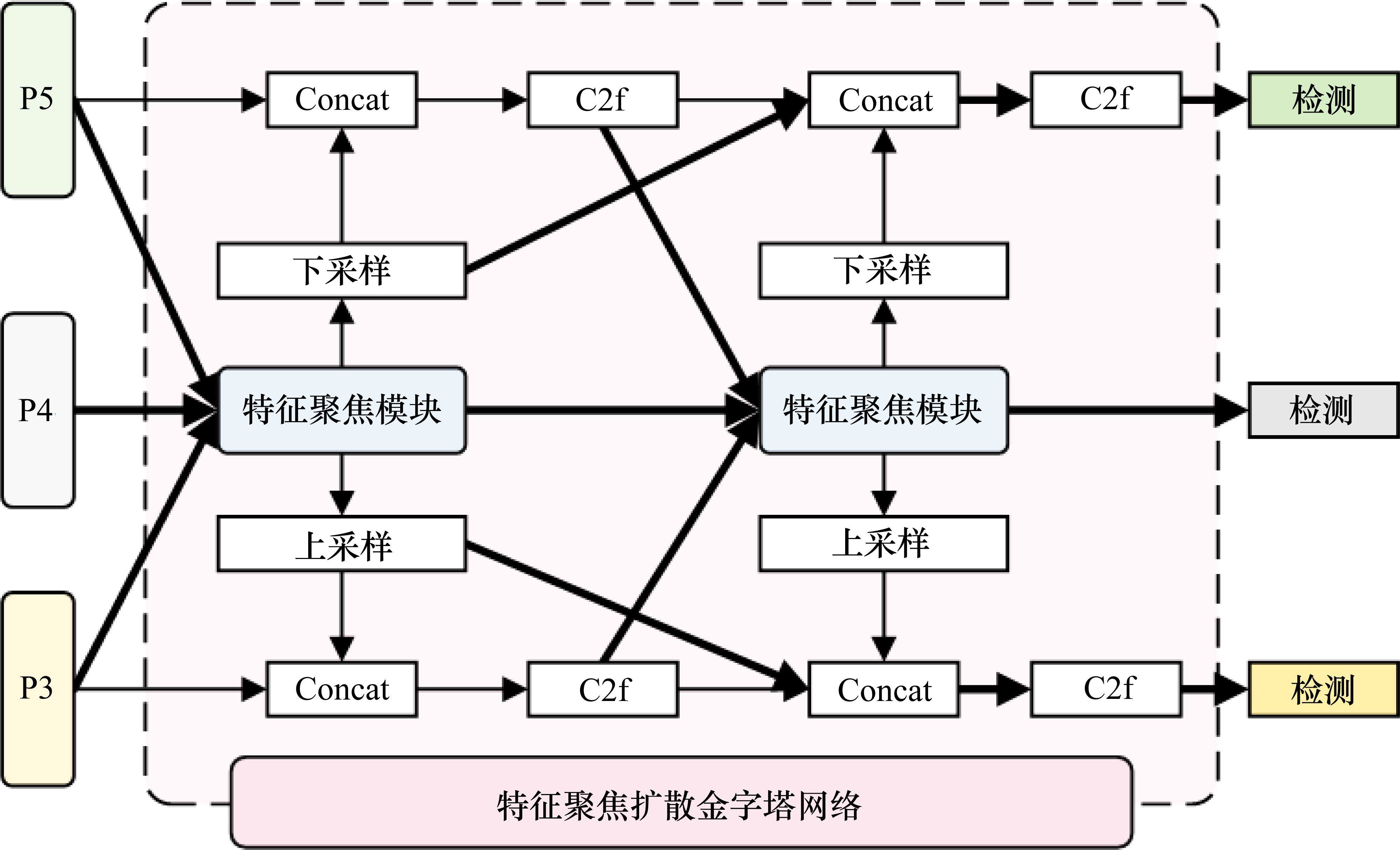

1.2 特征聚焦扩散金字塔网络

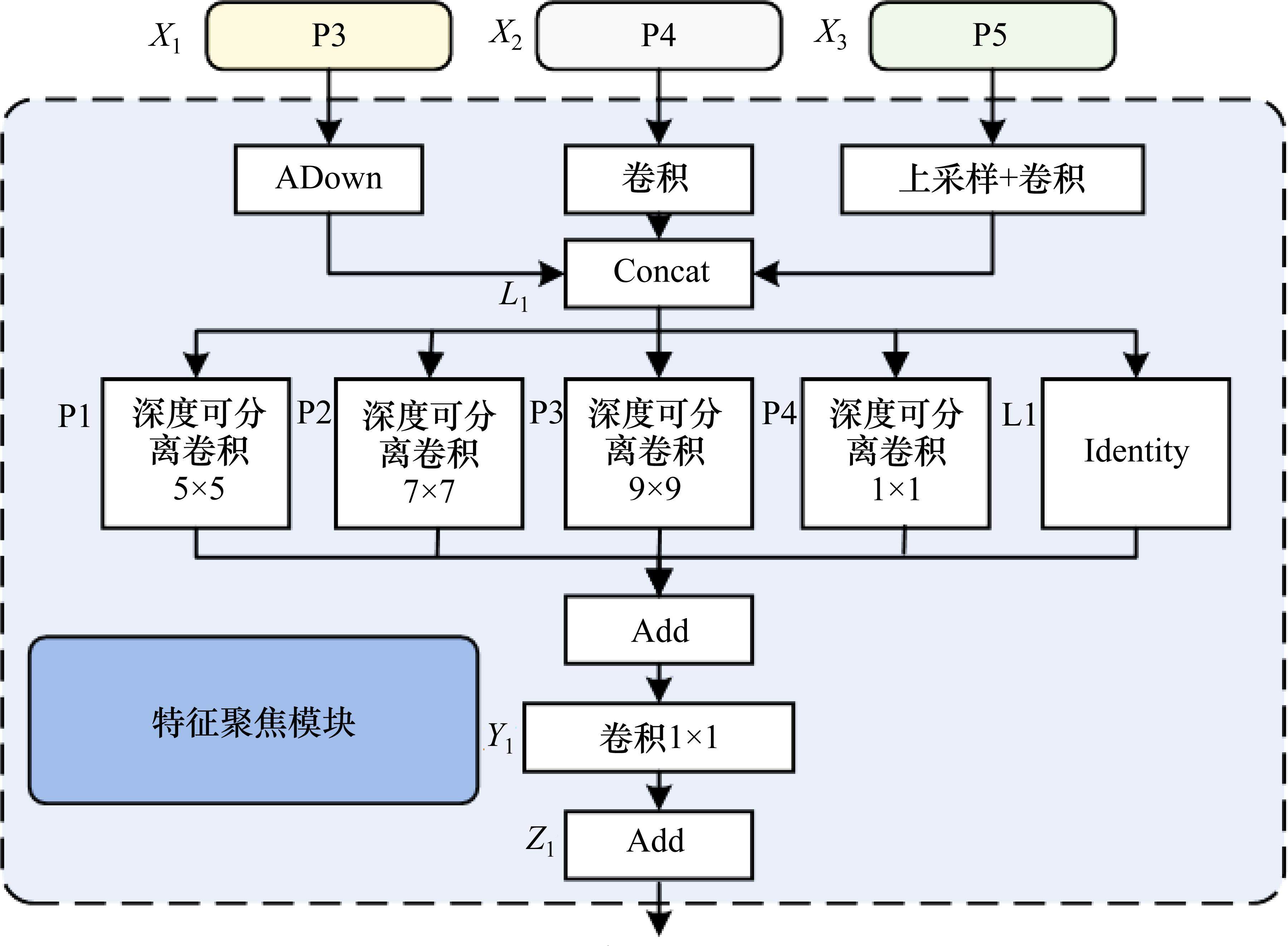

入侵至铁路限界区域的异物尺寸大小各异,且距离摄像机位置远近不同,而成像尺度各异的异物是检测中的难点问题,其中图像表征不明显、像素面积小的异物特征在深度较深的网络部分中易消失。因此本文设计了一种特征聚焦模块(Feature Focus Module,FFM),如图5所示。

其可以综合考虑不同尺度的特征,获得丰富的跨多个尺度的信息特征,提升网络对目标的检测能力。特征聚焦模块的输入是由主干网络中的P3、P4、P5层进行聚焦构成。P3进行了下采样操作,引入了YOLOv9[18]中的ADown下采样模块,该模块可优化卷积层的参数量,降低计算复杂度。P4层只进行卷积操作,保持了维度。P5层进行上采样操作与卷积操作。将处理后的P3、P4、P5层进行拼接,聚焦各层的局部信息,接下来用5个并行的深度可分离卷积来捕获多个尺度的上下文信息。模型内的数学表达如下:

其中,

其中,

进一步将FFM模型融入并改进检测网络中的颈部结构,构建特征聚焦扩散金字塔网络,如图6所示。原始YOLOv8模型中颈部网络是一种路径聚合网络和特征金字塔网络的结合。将FFM替换了中间层的C2f模块,并将P3、P4、P5接入第1个FFM,将其输出进行扩散操作,在1、3检测头之前的C2f模块前进行拼接操作,将不同尺度的特征信息传递至不同尺度的检测头中,通过扩散机制使具有丰富的上下文信息的特征扩散到各个检测尺度。特征聚焦模块与特征扩散机制,能让每个尺度的特征都具有详细的上下文信息,更有利于后续不同尺度目标的检测与分类。这种聚焦-扩散操作如图5中加粗线所示。

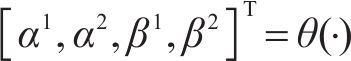

1.3 动态检测头

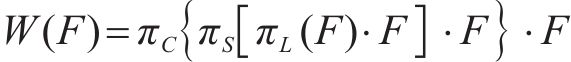

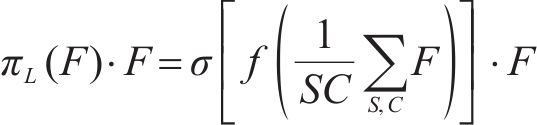

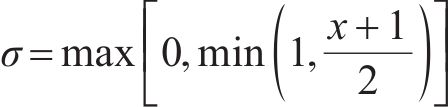

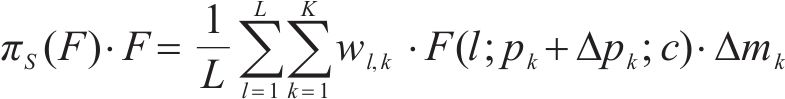

针对铁路入侵异物不同尺度,特别是小尺度目标的检测难题。为更好融合目标特征尺寸的多样性,本文在检测头网络中引入动态检测头[19](Dynamic head,Dyhead),其是一种基于注意力机制的动态目标检测头,集成了尺度注意力模块

其中,

尺度感知注意力

其中,f是用1×1大小的卷积层近似模拟的线性函数,

空间感知注意力模块

其中,

任务感知注意力模块

其中,

尺度注意力、空间注意力以及任务注意力可以进行多次的嵌套组合,将多个注意力模块有效堆叠在一起。本文将Dyhead引入到YOLOV8检测头前面,增强不同尺度目标检测能力,动态检测头模块的详细结构如图7所示。

1.4 Focal-EIOU损失函数

目标检测模型中,边界框回归损失函数是目标定位的重要步骤,并对模型的检测性能有直接关系。YOLOV8使用CIOU损失函数,CIOU存在以下问题[20]:1) 当预测框和真实框出现相同长宽比情况时,两者长宽比的比例一致性参数为0,导致无法发挥损失函数的作用。2) 锚框的长宽不能同时增减,会导致预测框无法更好拟合真实框。3) 长宽比无法有效反映预测框与真实框的真实差距。

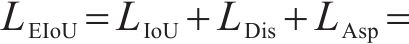

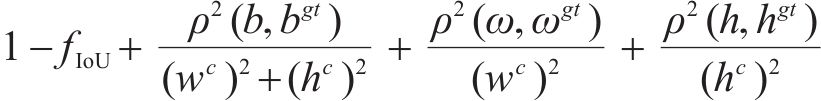

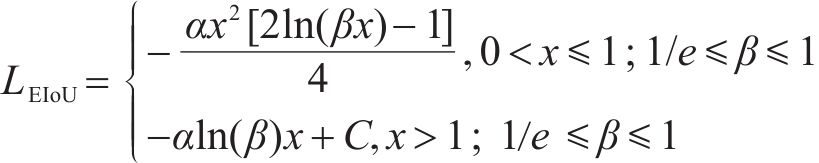

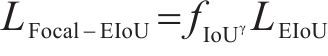

因此,针对CIOU存在的这些问题,引入了Focal-EIOU损失函数,其由Focal Loss和EIOU组成。Foccal Loss能够有效解决目标边界框回归过程中存在训练样本不平衡的问题;而EIOU融合了IOU损失、中心的距离损失和宽高比损失,能够从多方面综合度量预测框与真值之间的距离,经实验验证改进后的Focal-EIOU Loss具有更快的训练收敛速度和更精准的推理预测结果,数学表达如下:

该公式包含3种损失项:交并比损失LIOU,距离损失LDis以及方向损失LAsp。ρ()为2点的欧氏距离;wc是预测边界框与真实边界框的最小外接矩形的宽度;hc是预测边界框与真实边界框的最小外接矩形的高度。

目前入侵铁路限界的异物种类多样、难易程度各异,用于训练的正样本和负样本数量、种类、质量参差不齐,训练出来的检测模型泛化程度不高。因此采用Focal-EIOU损失函数,它通过调整权重,使高质量样本获得更高的权重,使检测模型对难样本的学习能力提高。

2 实验验证

2.1 数据集

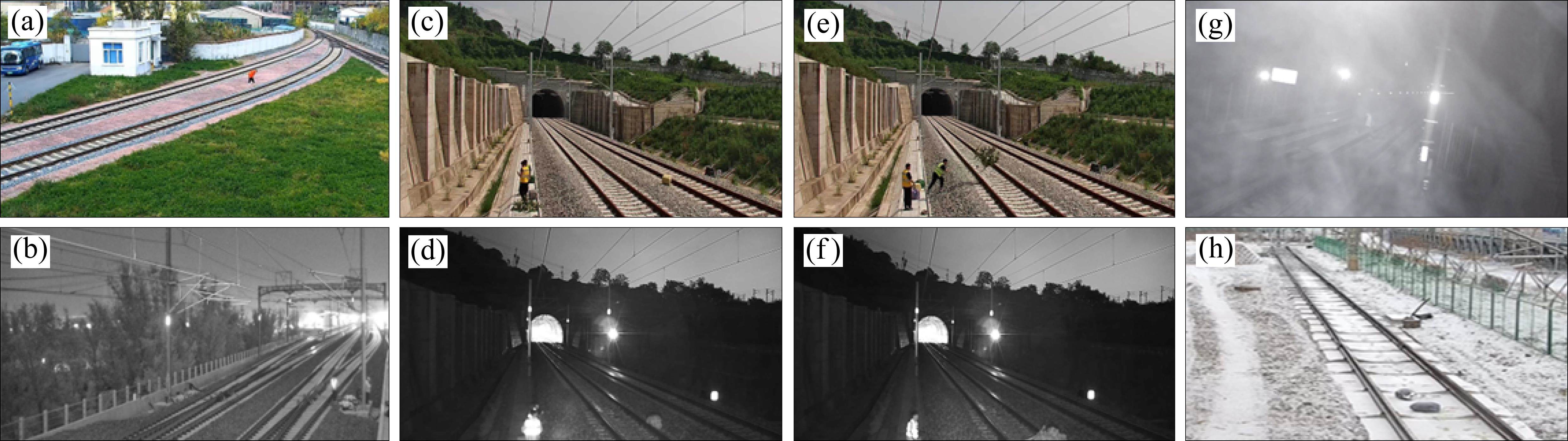

虽然铁路沿线发生落石、泥石流与人员入侵等危情的危害性很大,但相对于正常运行的铁路来说,沿线危情仍然是小概率事件,真实铁路危情样本极少。因此,本文利用铁路综合视频监控系统,在真实铁路环境中通过模拟道具进行铁路危情样本的模拟。根据铁路沿线监控摄像机部署特点,其监测范围一般在铁道限界区域,据此设计了铁路沿线危情模拟数据集的采集内容与方法。如图8所示,本文将铁路限界中上下行铁轨区域,分为1道、线间与2道区域,其中1道为最靠近监测摄像机的铁轨,2道为远离监测摄像机的铁轨,线间为1、2道之间的区域。

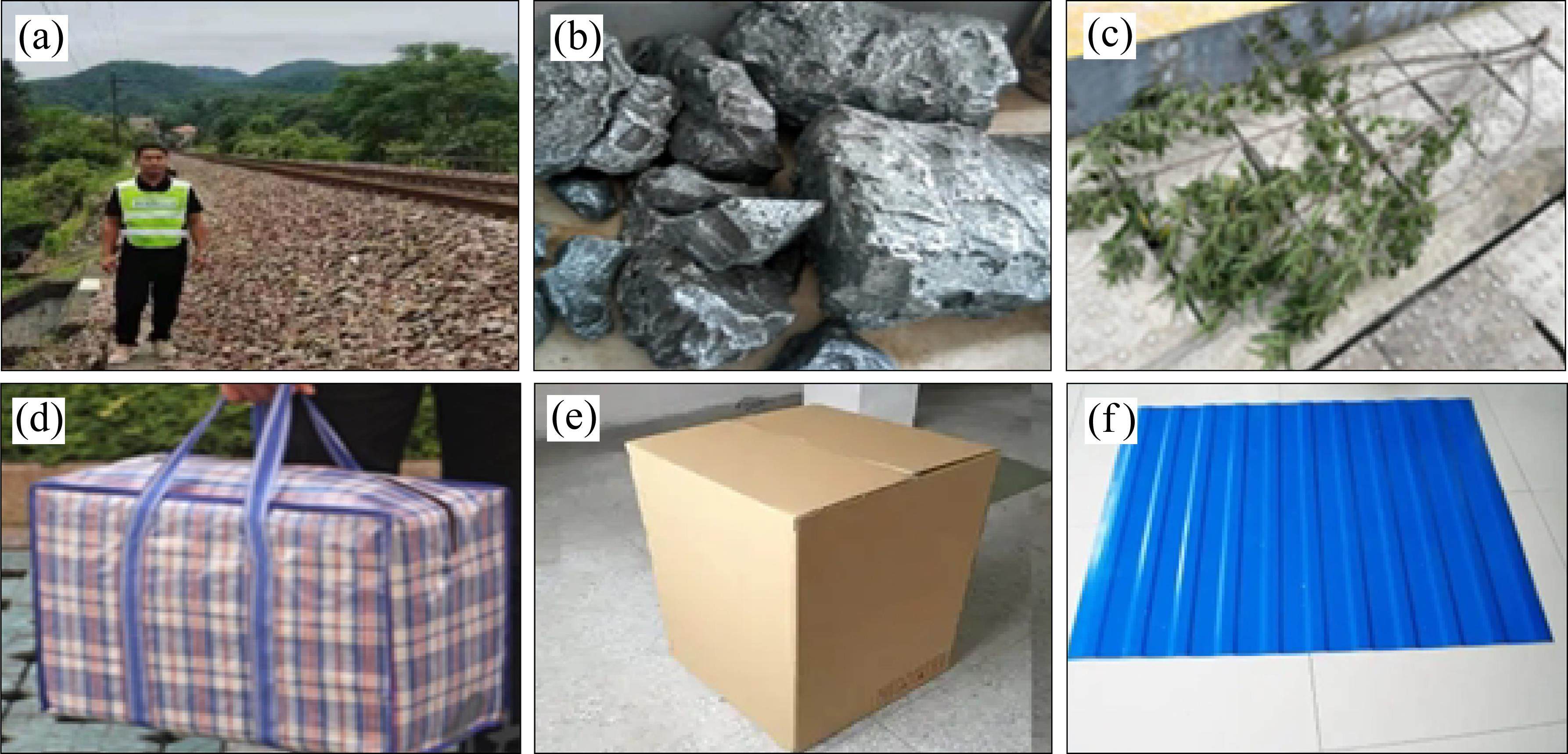

将轨面分为3个区域,在白天、夜晚以及不同天气状况下分别对异物与人员入侵进行模拟,对危情样本进行模拟采集异物样本采集方案如表1所示,模拟道具如图9所示。

| 类型 | 模拟方法 | 采集方法(正常天气/特殊天气) |

|---|---|---|

| 人员 | 横穿 | 整个防区,间隔5 m |

| 由远及近 | 整个防区,每隔10 m原地停留5 s | |

| 由近及远 | 整个防区,每隔10 m原地停留5 s | |

| 落石 | 抛入 | 整个防区,间隔2 m |

| 树枝 | 抛入 | 整个防区,间隔2 m |

| 包裹 | 抛入 | 整个防区,间隔2 m |

| 其他 | 抛入 | 整个防区,间隔2 m |

在铁路沿线不同的摄像机下,结合不同时间与天气环境进行铁路危情模拟,并进行录像,制作危情样本。最终标注铁路危情样本3.6万张。铁路危情数据集中典型统计数据如表2所示,按照目标不同尺寸对其进行了统计,将尺寸超过96像素×96像素的目标定义为大目标,尺寸介于32像素至96像素之间的目标视为中目标,而尺寸小于32像素×32像素的目标则归类为小目标,数据集部分样本图片如图10所示。

| 类别 | 子类别 | 数量 |

|---|---|---|

| 目标类型 | 人员 | 12 006 |

| 落石 | 13 517 | |

| 树枝 | 3 171 | |

| 包裹 | 2 900 | |

| 纸箱子 | 2 324 | |

| 彩钢板 | 2 082 | |

| 时间 | 白天 | 19 501 |

| 晚上 | 16 499 | |

| 天气 | 晴 | 29 136 |

| 雨雪雾 | 6 864 | |

| 目标大小 | 大目标 | 15 608 |

| 中目标 | 13 317 | |

| 小目标 | 7 075 |

2.2 实验参数与训练过程

实验的操作系统版本为Linux Ubuntu 20,torch版本为2.0.1,python版本为3.9,CPU为英特尔I9-12900K,GPU为英伟达GeForce RTX3090Ti×2。将采集、处理、标注的铁路危情样本数据,作为数据集,并按照80%训练集和20%验证集的比例进行划分。在训练阶段应用了Mosaic和Mixup等数据增强策略,迭代次数设置为300轮,batchsize为16,工作线程为8,优化器选用SGD。

2.3 性能评价指标

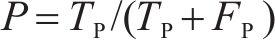

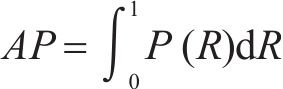

为了验证本文提出的方法的有效性,采用目标检测算法中常用的性能指标检测精度(mean Average Precision,mAP),该指标结合了准确率(Precision,P)与召回率(Recall,R)来评估检测性能。此外,在实际部署时,还需要兼顾检测速度(Frames per second, FPS)以及模型的参数量大小。

根据模型检测结果与Ground-Truth之间的关系,目标检测的结果可以被划分为4种类型:真正例(True positive,TP)、假正例(False positive,FP)、假负例(False negative,FN)、真负例(True negative,TN),这些分类将进一步用于定义模型的准确率与召回率指标。准确率为真正例相对于检测到有入侵例的比例,表征了模型的查准率,召回率为真正例相对于全部真正入侵例的比例,表征了模型的查全率,其计算方式

单从准确率和召回率较难全面评价模型的好坏,准确率高不能代表能够检测到尽可能多的真正例,高召回率也可能是过多将负例检测成正比。因此将二者结合起来才能更好评价模型的检测能力,每个类别的准确率P和召回率R绘制成P-R曲线,对该线进行积分,得到检测精度AP指标,其计算方式为

3 结果分析

3.1 主干网络改进模块对模型影响对比实验

为了验证改进模块FasterNet对模型的影响,将其替换了YOLOv8-m主干网络,并和原生的YOLOv8-m、YOLOv5-s、YOLOv7-tiny、YOLOv8-s模型进行了对比,实验结果如表3。由表3可知,更为轻量的s、tiny系列模型比m模型在召回率、准确率、mAP等指标上更低,但是FPS数值更高。其中,YOLOv7-tiny凭借最轻量的模型大小,在FPS数值上取得了最高数值289帧/s,但其mAP值也是最低值75.4%。模型最大的YOLOv8-m的mAP值也取得了最高值。本文改进模型的mAP值排名第2,比最高值的YOLOv8-m低了1.1个百分点,精度较为接近。与模型大小水平相近的YOLOv8-s相比,本文改进模型在精度比其高了5.8个百分点。FPS值比最高值YOLOv7-tiny低了9个百分点,与模型大小水平相近的YOLOv8-s相比,FPS值相差3帧。可见在相同模型大小上,取得最好的mAP值,在相近的mAP值的模型中,算法的FPS值最高,因此本文改进模型在平衡处理速率和识别精度上具有良好效果。

| 模型 | P/% | R/% | mAP/% | FPS/(帧∙s-1) | 模型大小/MB |

|---|---|---|---|---|---|

| YOLOv5-s | 77.1 | 78.9 | 79.3 | 266 | 7.2 |

| YOLOv7-tiny | 75.6 | 75.2 | 75.4 | 271 | 6.1 |

| YOLOv8-s | 83.7 | 82.5 | 84.3 | 247 | 11.2 |

| YOLOv8-m | 89.5 | 91.3 | 91.2 | 167 | 25.9 |

| FasterNet改进 | 88.8 | 89.3 | 90.1 | 244 | 13.3 |

3.2 特征聚焦扩散金字塔网络模块对模型影响对比试验

为检验FFM模块在模型对于不同尺寸、不同清晰度和不同特征目标的改进增益,基于YOLOv8m,在Neck部分增加BiFPN、RepGFPN、FFM模块进行横向对比实验。经实验验证发现:YOLOV8m融合BiFPN、RepGFPN层模型的训练精度增益低于FFM,且模型参数量和计算量大于FFM。只在P4层进行C2f模块替换与3层都进行替换的训练精度是相近的,但是模型推理速度更快,内存消耗更少,因此选择在P4层进行改进。

| 模型 | Size/(Pixels) | P/% | R/% | mAP/% | Param/M | Flops/B | FPS |

|---|---|---|---|---|---|---|---|

| YOLOv8m | 640×640 | 89.5 | 91.3 | 91.2 | 25.9 | 78.9 | 167 |

| YOLOv8m+BiFPN | 640×640 | 89.4 | 91.6 | 91.4 | 31.5 | 85.0 | 132 |

| YOLOv8m+RepGFPN | 640×640 | 89.6 | 91.2 | 91.3 | 28.3 | 82.1 | 135 |

| YOLOv8m+FFM(P3+P4+P5) | 640×640 | 91.5 | 92.3 | 92.3 | 29.8 | 83.4 | 141 |

| YOLOv8m+FFM(P4) | 640×640 | 91.6 | 92.1 | 92.2 | 27.1 | 79.5 | 156 |

为了进一步验证特征聚焦扩散金字塔网络模块对模型识别性能的影响,利用该模块对YOLOv8-m网络中的颈部结构进行了改进对比实验,实验结果如表5所示。其中小、中、大不同尺寸入侵目标的AP值分别用APS、APM、APL表示。由表5可知,优化后的模型AP值提高了2.6个百分点,大中小不同尺寸入侵目标的识别指标AP分别提升了0.5、1.3、6.0个百分点,指标的增强是逐步提升的,对小目标识别提升最为显著。可见在原生YOLOv8模型中,针对小尺度目标随着网络层数的增加,小尺度的细粒度特征信息会逐渐消失。通过特征聚焦模块,可将中小尺度的特征信息进行强化,并在颈部结构中,继续进行扩散操作,将特征信息传递至深层网络中,提高对中小尺度目标的识别能力。因此利用特征聚焦扩散金字塔网络模块对模型的中小目标的细粒度特征进行保留,可有效提升模型检测能力。

| 模型 | mAP/% | mAPS/% | mAPM/% | mAPL/% |

|---|---|---|---|---|

| YOLOv8-m | 91.2 | 83.9 | 92.8 | 96.9 |

| FFDPN改进 | 93.8 | 89.9 | 94.1 | 97.4 |

3.3 动态检测头模块对模型影响对比试验

为了验证动态检测头模块对模型识别性能的影响,利用该模块对YOLOv8-m网络中的检测头结构进行了改进对比实验,实验结果如表5所示。优化后模型的AP提升了1.1个百分点,针对大中小不同的入侵目标的识别指标AP提升了0.4、1.0、1.9个百分点,根据入侵目标的难易程度识别精准度指标会逐步提升,其中小目标识别提升相对明显。尺度感知注意力模块、空间感知注意力模块、任务感知注意力模块这3种改进结构强化了目标在检测头处特征,也将不同尺寸带来的特征多样性进行了更好融合,在检测时更易区分不同尺度、空间位置的目标特征,提升整体识别能力。

3.4 Focal-EIOU损失函数对模型影响对比试验

为了验证Focal-EIOU损失函数对模型识别性能的影响,利用该模块对YOLOv8-m网络训练过程进行改进,并做了对比实验,实验结果如表6所示。其中APPerson、APStone、APBough、APPackage、APOther分别表示人员、落石、树枝、包裹、其他等入侵目标的AP值。可以看出,针对不同类型入侵目标的识别指标AP均有所提升,其中人员、落石、包裹因为整体特征比较统一,类内特征差别小,所以优化后模型的AP提升较少,分别提升0.3、0.5、0.2个百分点,原生的YOLOv8-m已经具有较好的识别能力。但是针对类内特征差别较为复杂的树枝、其他(彩钢板、轻飘物等)入侵目标,其优化后模型的AP提升了较多,分别提升2.0个百分点和3.9个百分点,对样本少、难识别目标的识别提升最为显著。通过损失函数在不同类别与质量的样本进行不同权重设置,可以有效增强模型对这类样本关注,提高样本的学习能力,提升识别能力。同时,针对只进行EIOU改进的YOLOv8模型,在人员、落石、其他场景均取得比原生模型更好的表现,证明EIOU在提升不同侵限目标的识别率方面的有效性。

| 模型 | mAP | mAPS | mAPM | mAPL |

|---|---|---|---|---|

| YOLOv8-m | 91.2 | 83.9 | 92.8 | 96.9 |

| Dyhead改进 | 92.3 | 85.8 | 93.8 | 97.3 |

3.5 消融实验

为了评估本文提出的各个改进模块对模型效能的具体作用,设计了消融实验来逐一分析这些模块。在所有实验中,确保使用相同的数据集和一致的训练参数设置以保证实验的公平性。消融实验的结果展示在表7中,其中标记“√”表示在YOLOv8-m模型中采用了相应的改进方法,而“×”则表示未采用。由表8中结果可知,在本文的数据集上,本文的改进方法在检测精度指标上取得了提升,相比原生模型,mAP指标最终提升了3.7个百分点。其中,改进1降低了模型48.6%的参数量和49.0%的计算量,大幅提升了模型的FPS值,并使模型保持了与原生YOLOv8-m接近的mAP与Recall值。随着改进方法的不断叠加,mAP与Recall指标得到了不断提升。改进2相比原生模型mAP值提升了2.4个百分点、Recall值提升了1.2个百分点,特别的是其中的小目标APS提升幅度最大,提高了5.9个百分点,中、大目标分别提升了0.9个百分点、0.4个百分点,可见特征聚焦扩散网络模块对模型不同尺度目标检测能力提升的有效性。改进3相比原生模型mAP值提升了3.1个百分点、Recall值提升了2.5个百分点,在改进2的基础上mAP值又提升了0.7个百分点。小、中、大目标相对于改进2提升较为均衡,分别提升了0.9个百分点、0.8个百分点、0.4个百分点,可见动态检测头在均衡不同尺度目标特征在最终检测阶段的有效性,因为改进2的小目标识别能力提升较多,所以在改进3中基于改进2的提升较不明显,但相对于原生模型提升了6.8个百分点。改进4是所有改进集成形式,相比原生模型浮点数计算量降低了20.5%,而mAP值提升了3.7个百分点,其中小目标提升最大,提升了7.4个百分点,中、大目标分别提升了2.3个百分点、1.1个百分点,可知针对不同大小、类别的目标,本文所有改进方法既能减少模型的参数量和计算量又能有效提升不同情况下算法检测能力,使算法具有更好的实际应用效果。

| 模型 | APPerson | APStone | APBough | APPackage | APOther |

|---|---|---|---|---|---|

| YOLOv8-m | 97.5 | 92.9 | 86.9 | 94.6 | 83.9 |

| YOLOv8-m+EIOU | 97.6 | 93.1 | 86.8 | 94.6 | 85.4 |

| Focal-EIOU改进 | 97.8 | 93.4 | 88.9 | 94.8 | 87.8 |

| 模型 | FasterNet | FFDPN | Dyhead | Focal-EIOU | mAP/% | mAPS/ % | mAPM/ % | mAPL/ % | Recall/ % | Param/ M | Flops/ B | FPS/ (帧∙s-1) |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| YOLOV8m | × | × | × | × | 91.2 | 83.9 | 92.8 | 96.9 | 91.3 | 25.9 | 78.9 | 167 |

| 改进1 | √ | × | × | × | 90.1 | 82.8 | 92.6 | 94.9 | 89.3 | 13.3 | 40.2 | 244 |

| 改进2 | √ | √ | × | × | 93.6 | 89.8 | 93.7 | 97.3 | 92.5 | 15.4 | 46.3 | 213 |

| 改进3 | √ | √ | √ | × | 94.3 | 90.7 | 94.5 | 97.7 | 93.8 | 17.6 | 50.5 | 195 |

| 改进4 | √ | √ | √ | √ | 94.9 | 91.3 | 95.1 | 98 | 94.2 | 19.8 | 62.7 | 188 |

3.6 本文模型对比其他模型实验结果对比

本文选取了主流的目标检测模型,如两阶段检测法中的Faster RCNN,一阶段检测法中的YOLOv5-m、YOLOv8-m、YOLOv9-m、YOLOv10-m、YOLOv11-m和基于Transformer架构的RT-DETR,与本文提出的改进模型进行对比实验,进一步验证本文算法的有效性,实验结果如表8所示。可以看出,本文模型的AP值与其他模型相比有较大的提升,本文的AP较Faster RCNN、YOLOv5-m、YOLOv8-m、YOLOv9-m、YOLOv10-m、YOLOv11-m与RT-DETR高出25.5、7.0、3.7、3.1、3.0、3.3、3.2个百分点,证明本文模型在整体检测能力改进的有效性。特别是针对小尺度目标的AP值是所有方法中唯一达到90%以上的模型,可见在不同大小目标情况,本文方法能够较好保留不同尺度的细节特征信息,使模型能够在复杂的铁路环境下,检测各种形态各异的入侵目标。

| 模型 | P | R | mAP | mAPS | mAPM | mAPL |

|---|---|---|---|---|---|---|

| Faster RCNN | 68.3 | 70.1 | 69.4 | 60.8 | 74.6 | 72.8 |

| YOLOv5-m | 88.6 | 87.4 | 87.9 | 81.8 | 89.6 | 92.3 |

| YOLOv8-m | 89.5 | 91.3 | 91.2 | 83.9 | 92.8 | 96.9 |

| YOLOV9-m | 92.3 | 90.5 | 91.1 | 88.3 | 91.4 | 93.6 |

| YOLOV10-m | 92.1 | 91.3 | 90.9 | 89.5 | 90.8 | 92.5 |

| YOLOV11-m | 91.9 | 91.8 | 90.6 | 88.7 | 91.2 | 92.0 |

| RT-DETR | 91.1 | 92.6 | 91.7 | 82.7 | 94.7 | 97.7 |

| 本文模型 | 95.5 | 94.2 | 94.9 | 91.3 | 95.1 | 98 |

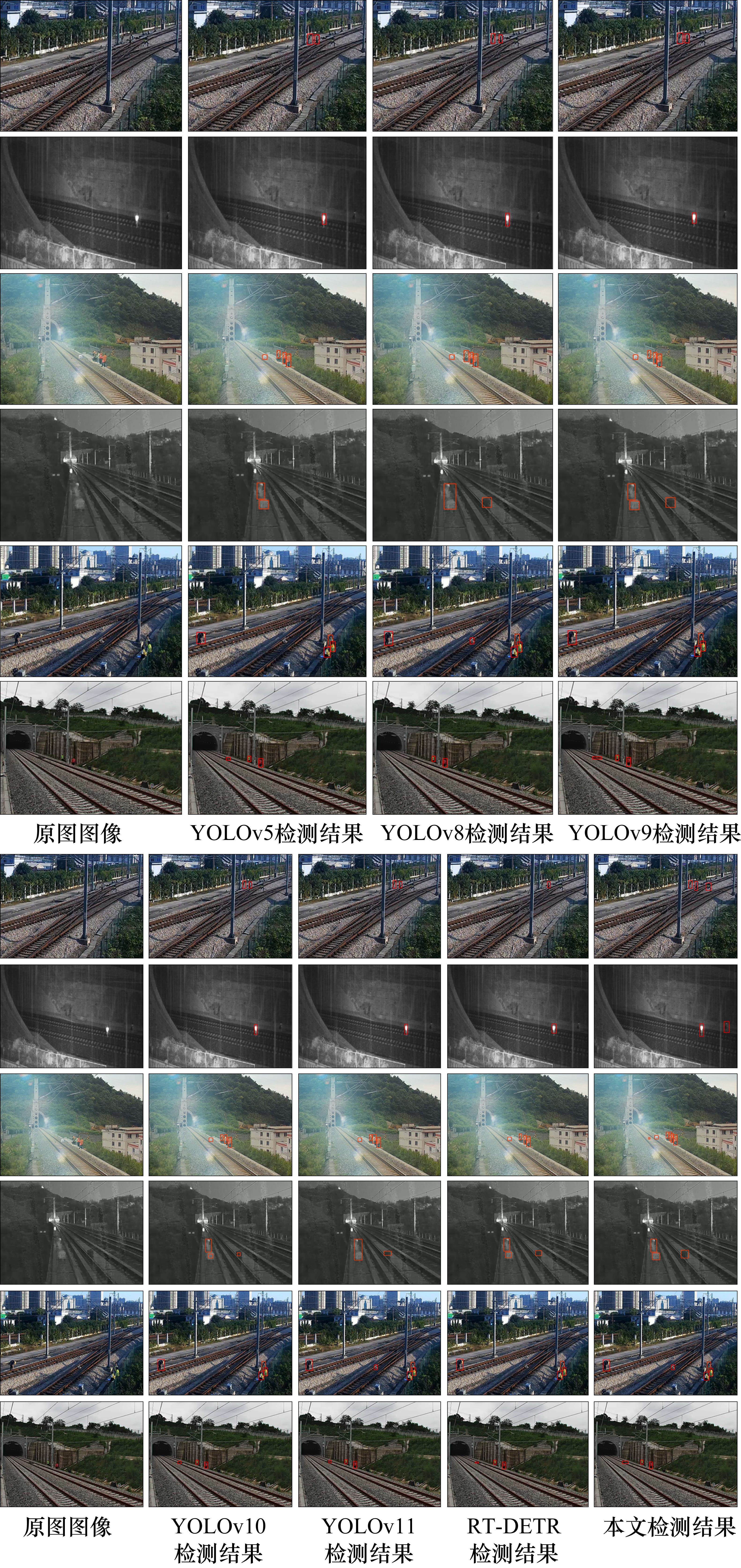

针对不同模型的对比实验的可视化结果如图11所示,选取了不同光照、天气条件下的试验用例进行了测试。图中第1列为入侵的原始图像,其余各列为不同模型的检测结果,因为Faster RCNN精度与其他模型差距较大,该模型的可视化结果不进行展示。其中第1行是白天远距离的行人入侵,共有3个行人目标,YOLOv5、YOLOv8、YOLOv9、YOLOv10、YOLOv11均识别到2个,RT-DETR只识别到1个,本文改进模型识别到全部3个。第2行是夜晚下雨天的行人入侵,在轨道中心的是穿戴反光衣的行人,所有模型均识别到这个行人,但是轨道边侧的没穿反光衣的人,除了本文改进模型以外均未识别到。第3行是白天炫光条件下的落石入侵,针对其中大块落石,所有模型均识别到,但是道心中小石头,只有本文的改进模型识别到;针对其中的人员,由于存在遮挡,除了本文改进模型全部识别到之外,其他模型均存在漏检。第4行是夜晚下雨天的落石入侵,因为雨滴干扰,画面较为模糊,道心中的大石头除了YOLOv5模型以外均识别到,其中本文改进模型目标框最为完整,轨旁的石头除了YOLOv8、YOLOv11以外其他均识别到。第5行是白天的包裹入侵,该类别样本较少,只有YOLOv8、YOLOv11与本文改进模型识别到。第6行为白天的树枝入侵,第2轨道的道心中树枝除了YOLOv8模型以外均识别到,其中本文改进模型目标框最为完整。因此,可知目标尺度较小、目标特征与背景较为相似的情况下,均表现出最好的识别能力,证明本文改进方法在不同情况的识别能力提升的有效性。

4 结论

1) 针对铁路异物入侵检测成本约束,将基准模型的主干网络进行轻量化改进,改进后模型相比基准模型,体量大小约为其50%,但识别精度能够到达相似水平,值降低了1.1个百分点,相比于其他轻量模型,具有最好的识别精度,为90.1%,证明该模型较好地平衡了计算消耗与检测能力。

2) 通过在颈部网络、检测头与损失函数方面的改进,可以有效提高模型在复杂环境与背景下的识别效果。利用特征聚焦扩散金字塔网络结构、动态检测头结构、Focal-EIOU损失函数,可有效将不同尺度大小、不同类别的入侵目标特征信息进行充分的传递与融合,有效地提升了目标特征的利用能力,实现了模型其目标检测能力的提升,综合改进后的模型相对于基准模型的检测精度提升了3.7个百分点,特别是针对小尺度目标提升最为明显,提升了7.4个百分点。并且针对较难识别的样本类型,提升也较多,提升了2个百分点以上。证明改进模型在复杂、小目标、难目标上检测的有效性。

3) 不同模型的对比实验结果与可视化结果,表明本文改进模型具有最好的识别精度。在复杂的夜晚下雨环境、远距离的小尺度入侵目标、样本少难识别的目标类别测试中,均表现出最好的识别效果。可见本文模型在铁路入侵用例场景中体现出较好的鲁棒性与实用价值。

YOLOv9: learning what you want to learn using programmable gradient information

[EB/OL]. 2024: 2402.13616. https://arxiv.org/abs/2402.13616v2.杨文,胡昊,李凌志等.基于机器视觉的铁路限界入侵检测方法[J].铁道科学与工程学报,2025,22(03):1328-1343.

YANG Wen,HU Hao,LI Lingzhi,et al.Railway boundary foreign object intrusion detection method based on machine vision[J].Journal of Railway Science and Engineering,2025,22(03):1328-1343.