截至2023年底,中国高铁运营总里程超过4.5万km,总里程位居全球第一。高速运行中的车辆,其车体各部位容易遭受外物撞击、牵引力和制动力以及震动的作用,造成列车表面的部件损伤,因此动车组列车表面故障检测变得尤为关键。TEDS利用轨边和列车底部安装的多组高速相机拍摄运行中列车的图片,通过网络实时传输至室内监测终端,采用人工或图像识别技术与其最近行驶的相同列车的历史图像比较,对列车表面故障进行检测。根据铁总运[2016]62号文TEDS检测列车的底板、裙板、车端连接处、转向架4部分,动车组表面部件种类繁多、结构复杂、会涉及诸多的细小和边缘特征,导致故障形态多种多样,使得既有的基于特征匹配[1]的图像故障检测误报率较高,故障定位不准确。李萍等[2]采用深度学习对铁路列车关键零部件进行故障检测,周雯等[3-4]提出了基于卷积神经网络的列车运行安全图像故障检测方法,相比较传统方法识别精度得到提升,但受限于收集到的列车运行故障图像数量少、且未考虑待检测的部件体积大小不一、图像质量低导致误报率高,使其不能在铁路现场应用,目前主要依靠人工与上次该列车经过时拍摄的图片进行特征差异对比排查故障部件。此外由于列车底部受车体的遮挡、夜间暗光、光照不均等情况下拍摄的图像存在亮度低、对比度差、细节信息损失严重无法精确获取物体特征,导致人眼视觉感知和后续高级视觉任务的检测准确度下降、检测效率低。随着监测范围的不断扩大,TEDS系统日监测动车组已突破1万列次,动车组车列图片量大,检测实时性要求高,人工检测作业强度不断增大。在检测时,图像的清晰度严重影响检测的准确度和效率,因此采取有效的图像暗光增强方法得到较清晰的图像是保证人工检测和图像自动检测准确率和效率的重要手段。暗光增强的主要任务是增强暗光图像的能见度和对比度,同时修复隐藏在黑暗中和由于提升亮度而引入的噪声、伪影、颜色畸变等复杂的图像质量退化。基于直方图均衡化[5]和伽马矫正等的传统图像暗光增强算法由于未曾考虑光照、物体和图像间的关系,增强后的图像失真大。近年来,深度卷积网络(CNN)在图像暗光增强上表现出优秀的性能,这些基于CNN的方法主要分为3类。第1类直接使用CNN来学习从暗光图像到正常光图像的蛮力映射函数[6-10],从而忽略人类的颜色感知,这类方法缺乏可解释性。第2类受照片编辑软件中亮度调整曲线的启发进行暗光增强,如GUO等提出Zero-DCE[11]、Zero-DCE++[12]、ZHANG等提出的ReLLIE[13]依据输入图像反复应用二阶曲线嵌套并通过CNN自适应调整曲线参数以达到图像暗光增强的目的。虽然该类方法在训练过程不需要成对的数据,但其未过多考虑暗光照片中的噪声抑制问题,对特定场景中的暗光效果不能达到最优。第3类是基于Retinex理论[14]的深度卷积网络图像暗光增强方法[15-19],该类方法采用Retinex理论将原始低照度图像I分解为光照图像L和反射图像R,随后采用CNN分别对反射图像去噪、调整照明进行暗光增强,但多CNN耦合使得网络结构复杂,训练过程繁琐且耗时。自注意力机制[20]可以建立全局的依赖关系,捕获特征之间的长程依赖性和非局部自相似性,扩大图像的感受野,在目标检测[21-22]、图像复原[23]等领域等到了广泛应用。CAI等[24]提出的Retinexformer,采用照明引导的多头自注意力(IG-MSA)利用视觉Transformer通过曝光良好的区域为曝光不足的区域提供依赖信息进行暗光增强。虽然通过采用调整多头自注意力计算中查询(Q)、键(K)、值(V)的运算顺序,使其运算复杂度由平方复杂度降低为线性复杂度,在提高计算速度的同时暗光图像增强取得了较好的效果,但其计算过程中相似度的最大秩减小,导致其特征多样性降低,特征多样性通常是网络表征能力的重要体现。故本文基于降低注意力计算复杂度和提高相似矩阵秩以提高特征多样性,提出采用聚焦线性注意力优化的Retinexformer网络(RetinexFLAformer)对TEDS图像进行暗光增强研究,主要内容如下:1) 采用聚焦线性多头注意力[25]机制优化IG-MSA模块,在降低计算复杂度至o(d2WH)的同时解决相似度矩阵的低秩问题,提高网络特征多样性;2) 根据Retinex原理,结合照明引导的多头线性聚焦自注意力(IG-MFLSA)搭建一阶段干扰退化修复网络进行TEDS图像的暗光增强;3) 进一步优化损失函数和网络结构,减小计算复杂度并提高网络暗光增强的质量。

1 Retinexformer图像暗光增强方法

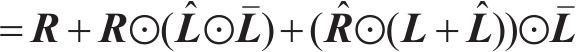

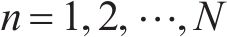

根据Retinex理论,一个低光图像I可以分解为一个反射图R和一个照度图L的点乘:

其中,

在提升暗光图像亮度时,上边等式两边会同时点乘一个光照估计

其中,

其中,

其中,

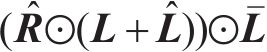

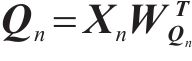

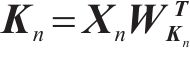

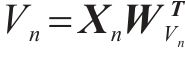

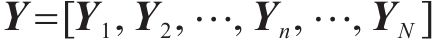

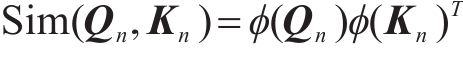

IG-MSA计算过程:首先输入特征

其中,

同一图像黑暗区域具有更严重的信息损失和干扰,且更难恢复,照明良好的区域可以提供语义上下文表示,以帮助增强暗光区域。因此,使用照明特征

其中,

其中,

2 RetinexFLAformer网络实时图像暗光增强

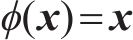

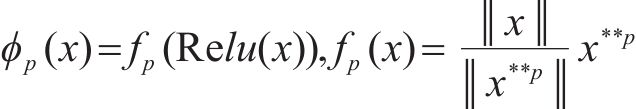

2.1 聚焦线性自注意力原理

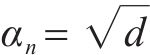

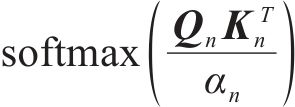

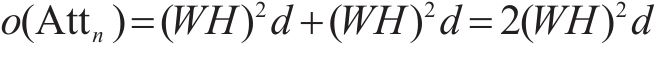

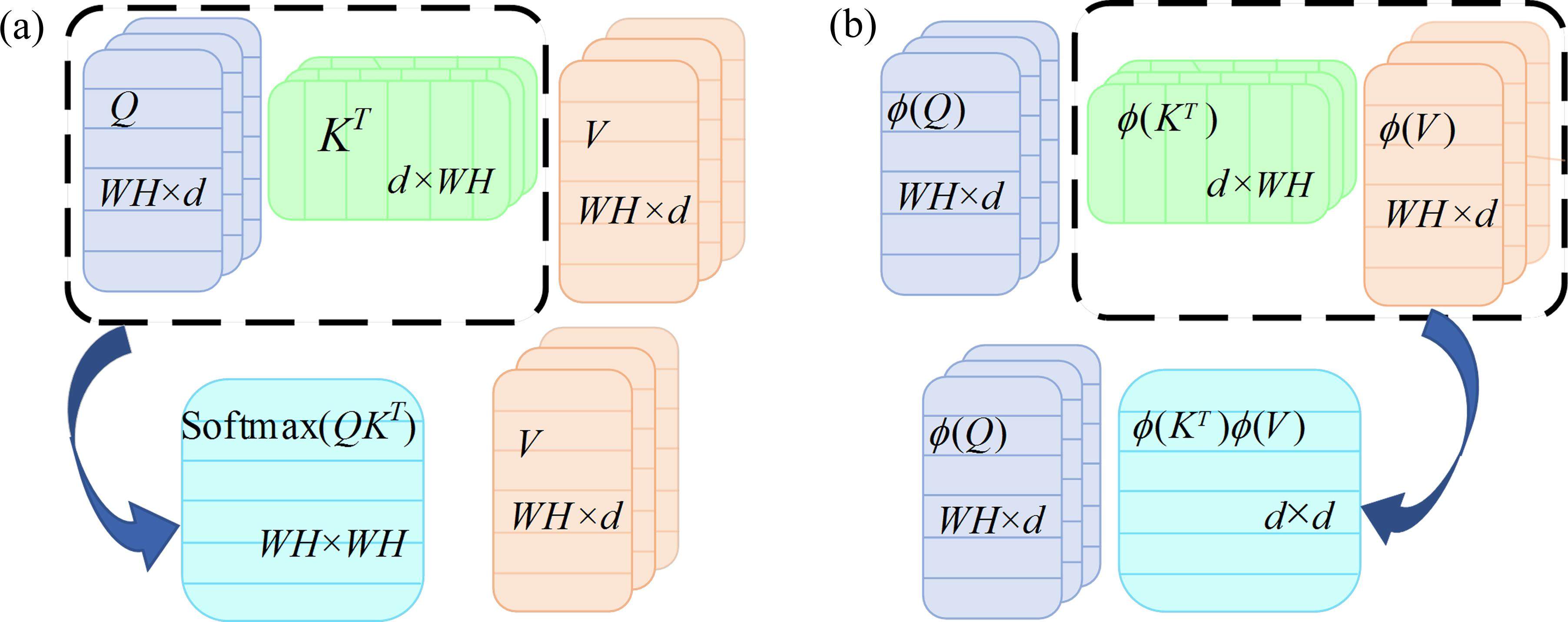

虽然上节所述Retinexformer框架采用倒残差深度可分离卷积,在IG-MSA中通过调整Q,K,V的计算顺序

传统多头注意力:多头注意力对每个头的计算可用式(9)表示,其中

其计算复杂度如下所示:

计算复杂度与

若

则根据矩阵乘法的结合性可将计算顺序从

其中,

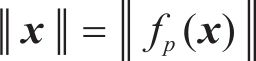

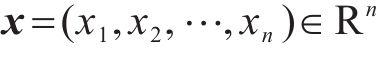

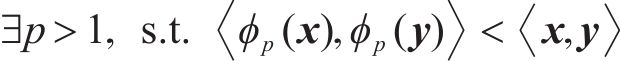

命题1(

当

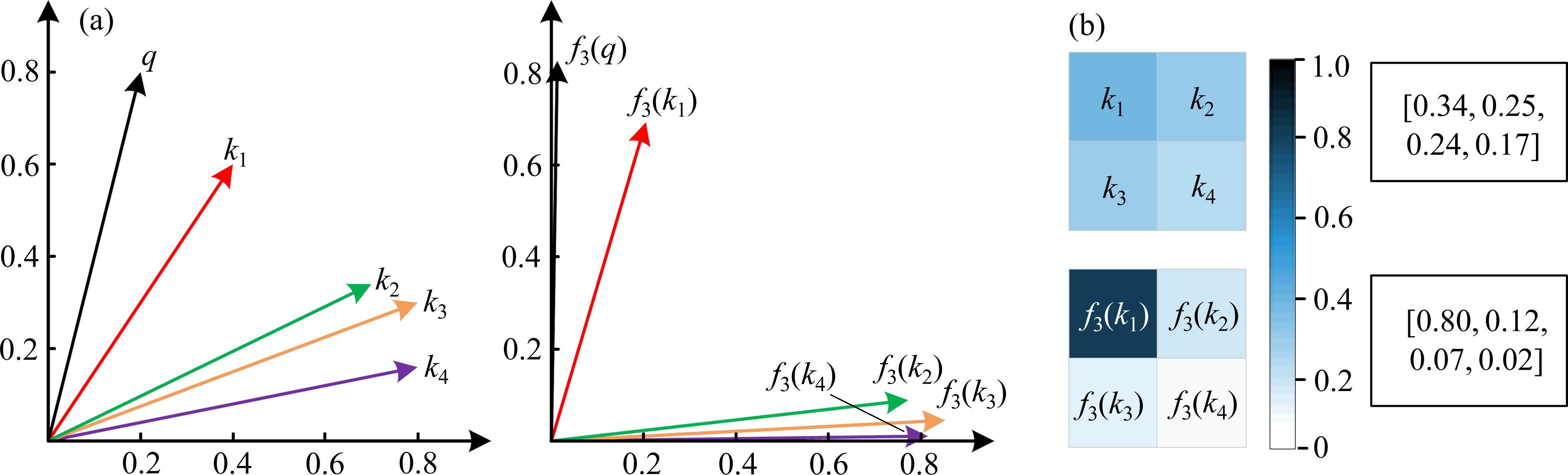

图2以二维向量为例给出了

2.2 注意力矩阵增秩方法及分析

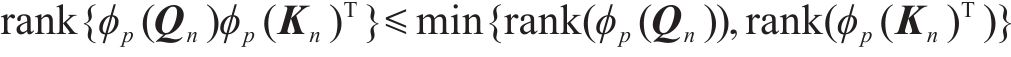

除注意力聚焦,特征多样性也是限制注意力表达能力的因素之一。线性聚焦注意力中注意力矩阵秩的大小由WH和d决定,即:

线性注意力矩阵秩的上限被限制在较低的值,这表明注意力矩阵的许多行严重同质化。由于自注意力的输出是同一组

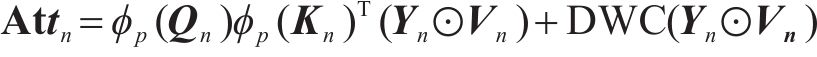

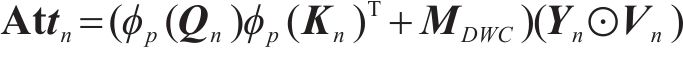

进一步输出特征图可表示为

故DWC视为一种注意力,在这种注意力中每个查询只关注特征空间中的几个局部特征,而不是所有特征V,这种局部性确保了即使2个查询对应的线性注意力值相同,仍然可以从不同的局部特征中获得不同的输出。

基于上述分析,聚焦线性注意力首先采用式(13)所示的映射函数来模仿softmax对注意力的大幅度调整。在此基础上,采用简单的深度卷积解决线性注意力模块中的低秩问题来恢复特征多样性。由此聚焦线性注意力模块可以享受线性计算复杂度和高特征多样性表示。由此采用该注意力机制模块替代原RetinexFormer中的注意力构成聚焦线性注意力RetinexFLAformer网络结构,用于TEDS图像去模糊。

2.3 改进的网络结构

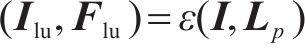

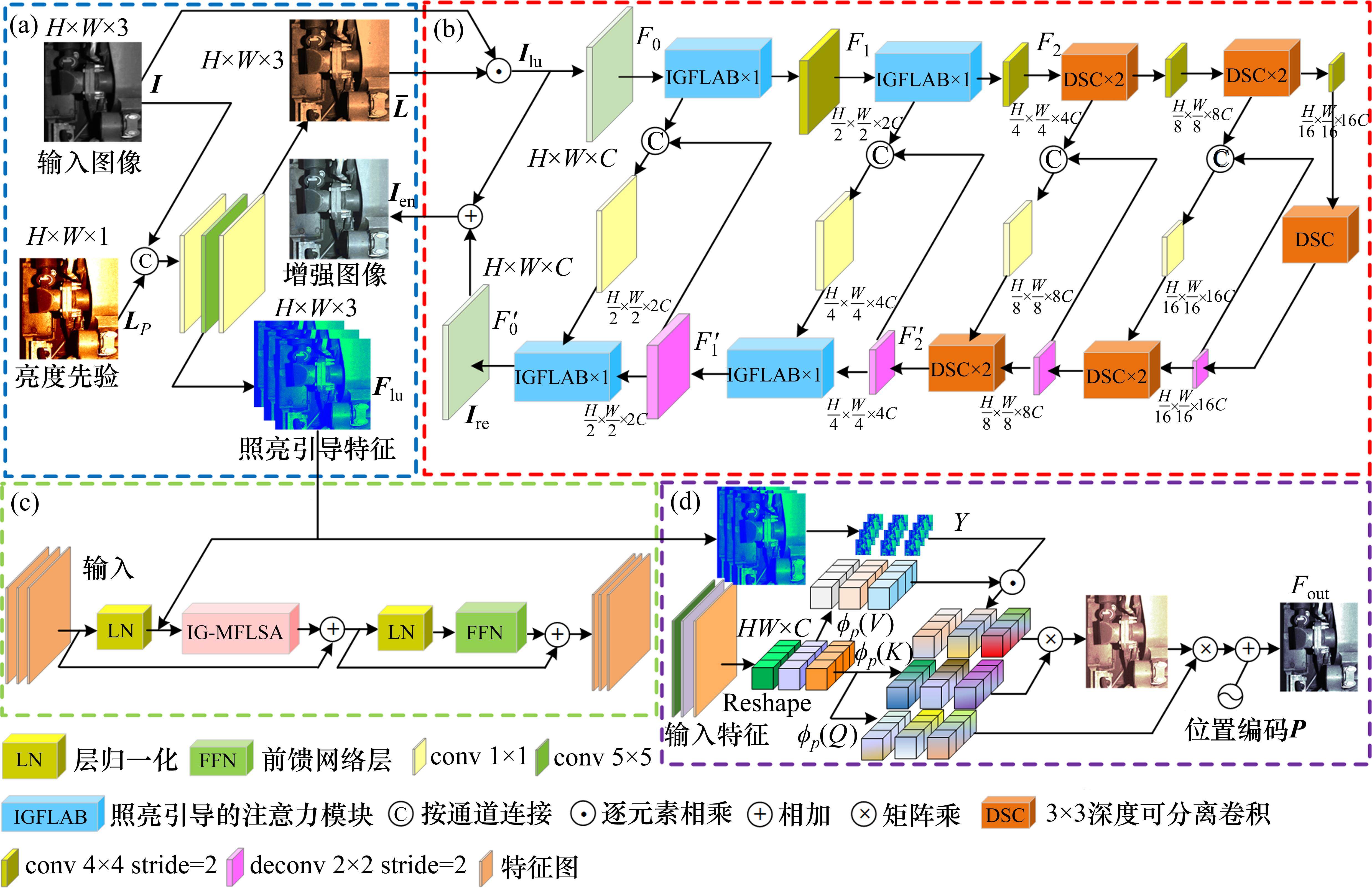

一阶段暗光增强RetinexFLAformer网络结构如图3所示,根据采用IGFLAB个数的不同,构建RetinexFLAformer和FastRetinexFLAFormer(速度更快)2种网络结构,用以研究暗光增强效果和运行速度的平衡。其中图3(a)根据Retinexformer[24]实现照明估计器的功能,首先使用1×1卷积融合

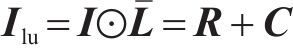

IGT运算过程:

IGFLAB结构描述:如图3(c)所示,由

IG-MFLSA计算过程:首先对输入采用和IG-MSA相同的处理方式生成向量

2.4 损失函数

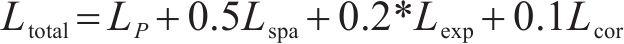

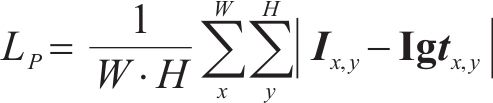

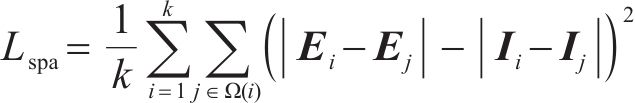

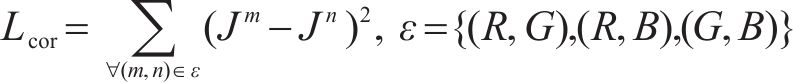

为进一步提高由于增强网络和曝光不均引起的局部区域对比度下降问题,加入空间一致性损失、曝光控制损失和颜色恒定性损失,以提高暗光增强效果,由此损失函数定义如下:

其中,

其中,

为了抑制曝光不足/过度的区域,采用曝光控制损失

曝光控制损失计算局部区域的平均强度值

其中,

3 实验与分析

3.1 训练数据库

本文将某局TEDS系统获得的一趟低速且曝光良好的列车TEDS图像,共1 437张组成清晰图像,对其加入不同程度的暗光和噪声生成成对的高清、暗光图像对,随机抽取1/4作为验证集,其余作为训练集。为进一步提高图像集特征信息和网络对暗光增强的泛化能力,将TEDS图像集合并入LOLv1数据集用于网络的训练。

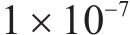

3.2 训练策略

采用从头开始训练的策略,采用adam优化器,训练周期设置为150 000个epoch,初始学习率设置为

3.3 实验结果与分析

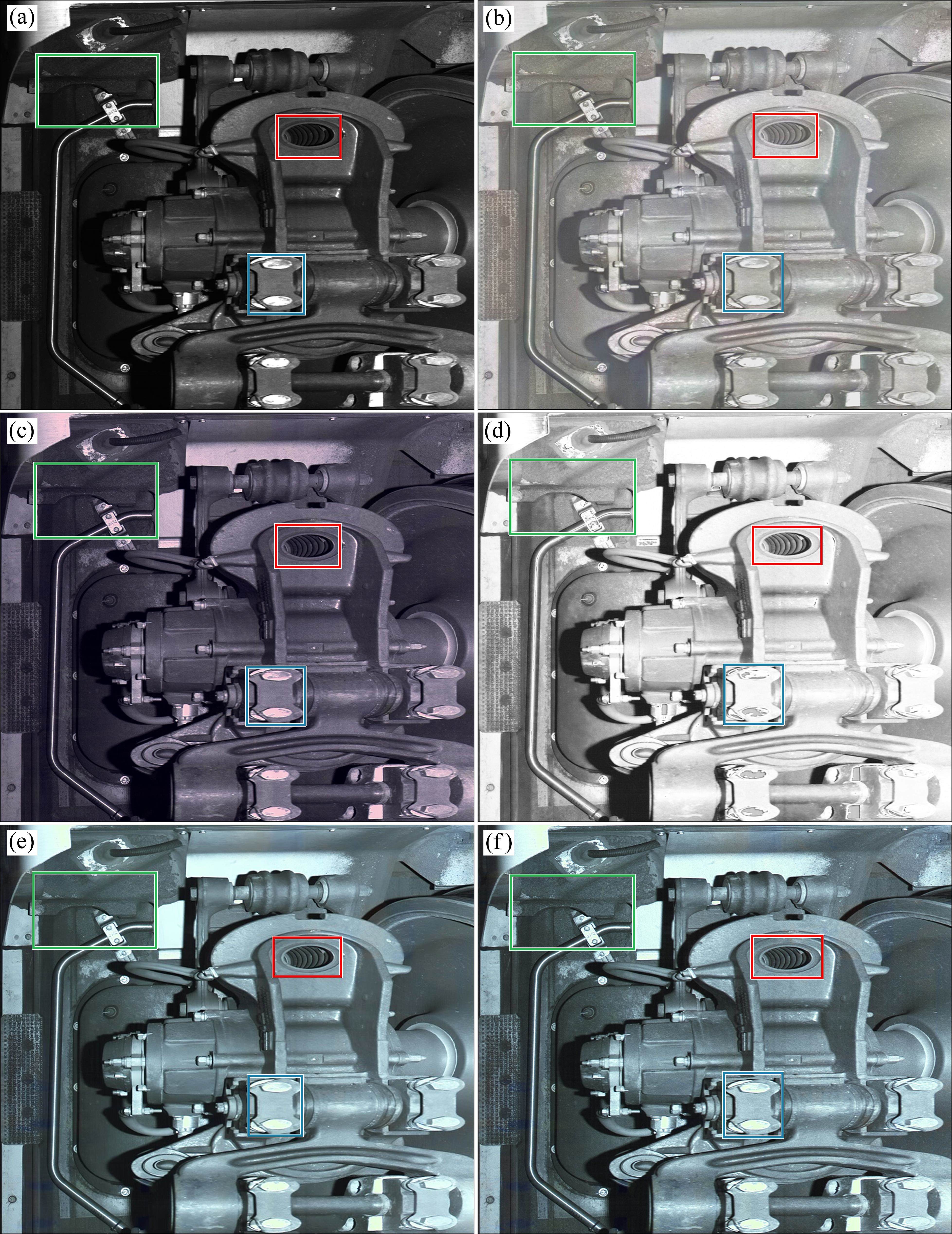

为验证本文算法的有效性和先进性,将本文算法与其他3种暗光增强算法Zero-DCE++[12]、EnlightenGAN[10]、Retinexformer[24]进行对比,图4所示为上述3种算法和本文所采用算法对TEDS现场图像的暗光增强效果。图4(a)为从某局获取的TEDS系统采集的暗光图像;从图4(b)可看出经Zero-DCE++算法处理后,大部分区域比原图有更好的清晰度和分辨性,但图像整体受光照增强有一层朦胧感;图4(c)所示为EnlightGAN的增强效果,大部分区域有一定的增强效果,但对过分偏暗的区域(绿色大矩形框)特征轮廓和边缘对比度提升不太明显;从图4(d)可看出,经算法Retinexformer处理后,清晰度较Zero-DCE++、EnlightGAN有所提升,大部分区域(绿色和红色矩形框)边缘和轮廓特征清晰可见,但蓝色框定区域受局部高亮区域的影响对比度下降,在该区域表现出不如原图和其他方法的辨识效果;图4(e),图4(f)为本文设计的RetinexFLAformer的处理结果,较其他方法在整个图像上有更好的对比度,绿色和红色矩形框定区域的因暗光导致的模糊区域经恢复后轮廓清晰可见,蓝色正方形框定区域较原Retinexformer对比度提升明显,从整体上取得了比上述3种算法更好的去模糊效果,且RetinexFLAformer网络有一定的干扰修复功能,图像质感比其他算法更好;其中图4(f)为对网络结构改进后更快的FastRetinexFLAformer,较图4(e)亮度和对比度非常接近,增强效果比其他3种算法更好。

本文采用PSNR、SSIM和运行速度3种评价指标对本文算法的暗光增强效果进行分析,各算法的评价指标如表1所示,由此可看出Zero-DCE++对TEDS测试集的PSNR为15.79,SSIM为0.588,比其他算法略低,原因在于Zero-DCE采用非配对的暗光和亮光图像进行训练调整亮度曲线,不能很好地抑制暗光引起的噪声干扰。EnlightenGAN对TEDS测试集的PSNR为16.94,SSIM为0.631,比Zero-DCE++有所提升。Retinexformer对TEDS测试集的PSNR达到23.96,SSIM达到0.801,指标比前2种算法大幅度提升。改进的RetinexFLAformer的PSNR和SSIM分别较Retinexformer提升0.55和0.023,达到24.51和0.824,取得了比前3种算法更好的评价指标值。此外通过改进网络结构构建的FastRetinexFLAformer运行速度可达0.26 s/张,是EnlightenGAN处理速度的2.7倍。但其PSNR较指标最高的RetinexFLAformer算法只降低0.39,SSIM降低0.013,能很好地平衡暗光增强效果和运行速度。此外采用和现场同配置的Intel i7处理器进行验证,处理速度可达1.02 s/张,能满足铁路TEDS对计算机硬件成本和实时性的要求。

| PSNR | SSIM | 参数大小 | TEDS运行速度/ (s∙张-1) | |||

|---|---|---|---|---|---|---|

| TEDS | LOLv1 | TEDS | LOLv1 | |||

| Zero-DCE++ | 15.79 | 16.72 | 0.588 | 0.594 | 51.1 K | 5.76 |

| EnlightenGAN | 16.94 | 17.44 | 0.631 | 0.650 | 34.6 M | 0.71 |

| Retinexformer | 23.96 | 24.41 | 0.801 | 0.822 | 6.48 M | 1.17 |

| RetinexFLAformer | 24.51 | 24.96 | 0.824 | 0.837 | 6.45 M | 1.24 |

| FastRetinexFLAformer | 24.12 | 24.51 | 0.811 | 0.822 | 3.34 M | 0.26 |

同时对网络结构进行调整并进一步实验,在对IGFLAB个数调整为1后,若不加2级下采样和上采样卷积层,则PSNR较FastRetinexFLAformer降低3.03~21.09,下降较为明显。说明调整IGFLAB的个数后参数量大幅度下降对暗光增强影响较明显,故为使得效果提升且基本不影响速度的提升,加入了2级下、上采样卷积层作为U_Net网络的补充,指标值得到恢复。由此也说明采用的线性聚集注意力能通过

为验证改进措施的有效性,采用逐步增加改进措施的方式进行如表2所示的消融实验。首先采用聚焦线性注意力模块取代原Retinexformer的注意力模块后,PSNR和SSIM较Retinexformer分别提升0.35和0.006,说明采用线性聚焦注意力能取得原注意力机制中softmax对特征关注度的调整(对感兴趣特征增强,对不感兴趣特征减弱)类似的效果,且能通过增强相似矩阵的秩提高特征多样性,达到好的暗光处理效果。相似矩阵增加DWC

| 改进策略 | PSNR | SSIM |

|---|---|---|

| Retinexformer | 23.96 | 0.801 |

| +线性聚焦注意力 | 24.31 | 0.807 |

| +DWC(Vn) | 24.43 | 0.815 |

| +改进损失函数 | 24.51 | 0.824 |

4 结论

TEDS承担着对高速列车机械类故障进行实时检测的重要任务,针对TEDS系统提高人工检测和智能检测效率和准确率这一问题,设计了RetinexFLAformer网络对TEDS图片进行实时暗光增强研究。

1) 对原Retinexformer的多头注意力机制进行分析,采用聚焦线性注意力对照明引导的多头注意力模块进行优化,实验证明聚焦线性注意力能有效聚焦相似特征,增加Q和K相似特征的权重,减小非相似特征的权重,达到和softmax基本一致的相似权重分配效果。

2) 聚焦线性注意力能解决原Retinexformer相似矩阵低秩的问题,且通过在相似矩阵上追加DWC

3) 空间一致性损失、曝光控制损失和颜色恒定损失作为像素L1损失的有效补充,能有效提高暗光增强的对比度、抑制颜色畸变。

本文算法处理后的TEDS图像比其他主流暗光增强算法有更好的对比度和清晰度,评价指标PSNR和SSIM都有提升。且检测网络有很小的参数量和较小的计算量,且可取较其他算法多倍的速度提升,能满足TEDS系统的实时性检测需求,可用于高速铁路TEDS系统故障识别的图像前期暗光增强处理,提高缺陷、故障等安全隐患检测识别的精准度,提升检测人员的工作效率,更好地保障铁路安全运行。

目前TEDS现存的故障缺陷样本少、部件结构复杂且缺陷形态多样,图片质量差,导致目前TEDS系统故障检测算法误报率高,后续可在图像增强的基础上进一步研究基于半监督学习的特征差异对比深度网络以提高TEDS故障检测的准确率,减轻人工检测强度。

借助弱纹理匹配的TEDS车底故障区域定位算法

[EB/OL]. 智能系统学报, 2023: https://link.cnki.net/urlid/23.1538.TP.20230914.1045.006.王登飞,苏宏升,陈光武等.基于聚焦线性注意力Retinexformer的TEDS图像实时暗光增强方法研究[J].铁道科学与工程学报,2024,21(11):4840-4850.

WANG Dengfei,SU Hongsheng,CHEN Guangwu,et al.Real time low light enhancement method of TEDS images based on focused linear attention Retinexformer[J].Journal of Railway Science and Engineering,2024,21(11):4840-4850.